Open-Sora wurde in der Open-Source-Community stillschweigend aktualisiert! Ein einzelnes Objektiv unterstützt jetzt die Videogenerierung von bis zu 16 Sekunden in Auflösungen bis zu 720p und kann jedes Seitenverhältnis Text-zu-Bild, Text-zu-Video, Bild-zu-Video, Video-zu-Video und Videogenerierung in unbegrenzter Länge verarbeiten Bedürfnisse. Probieren wir den Effekt aus.

Erstellen Sie eine horizontale Weihnachtsschneeszene auf dem Bildschirm und veröffentlichen Sie sie auf der B-Site

Erstellen Sie erneut einen vertikalen Bildschirm und machen Sie Douyin

Es können auch lange Videos mit einer einzigen Aufnahme von 16 Sekunden erstellt werden, jetzt kann jeder süchtig nach Drehbuchschreiben werden.

Spielanleitung? Wegbeschreibung zu GitHub: github.com/hpcaitech/Open-Sora

Was noch cooler ist, ist, dass die neueste Version von Open-Sora immer noch Open Source und voller Aufrichtigkeit ist. Das Warehouse enthält die neueste Modellarchitektur, die neuesten Modellgewichte, Multizeit-/Auflösungs-/Seitenverhältnis-/Bildraten-Trainingsprozesse und Datenerfassung und Der komplette Prozess der Vorverarbeitung, alle Schulungsdetails, Demobeispiele und ausführliche Tutorials für den Einstieg .

1. Umfassende Interpretation technischer Berichte

Kürzlich hat das Autorenteam von Open-Sora offiziell die neueste Version des technischen Berichts [1] auf GitHub veröffentlicht. Im Folgenden werden wir den technischen Bericht zur Interpretation der Funktionen, Architektur, Trainingsmethoden, Datenerfassung, Vorverarbeitung usw. verwenden Aspekte nacheinander.

1.1 Übersicht über die neuesten Funktionen

Dieses Update von Open-Sora umfasst hauptsächlich die folgenden Hauptfunktionen:

- Unterstützt die Generierung langer Videos;

- Die Auflösung der Videoerzeugung kann bis zu 720p erreichen;

- Ein einziges Modell unterstützt jedes Seitenverhältnis, verschiedene Auflösungen und Dauer von Text-zu-Bild, Text-zu-Video, Bild-zu-Video, Video-zu-Video und unbegrenzte Anforderungen an die Videogenerierung;

- Vorschlag eines stabileren Modellarchitekturdesigns, das Multizeit-/Auflösungs-/Seitenverhältnis-/Bildratentraining unterstützt;

- Der neueste automatische Datenverarbeitungsprozess ist Open Source;

1.2 Raum-Zeit-Diffusionsmodell

Dieses Upgrade von Open-Sora hat wichtige Verbesserungen an der STDiT-Architektur in Version 1.0 vorgenommen, mit dem Ziel, die Trainingsstabilität und die Gesamtleistung des Modells zu verbessern. Für die aktuelle Sequenzvorhersageaufgabe übernahm das Team die Best Practices großer Sprachmodelle (LLM) und ersetzte die sinusförmige Positionskodierung in der zeitlichen Aufmerksamkeit durch die effizientere Rotationspositionskodierung (RoPE-Einbettung).

Um die Stabilität des Trainings zu verbessern, verwiesen sie außerdem auf die SD3-Modellarchitektur und führten außerdem die QK-Normalisierungstechnologie ein, um die Stabilität des Trainings mit halber Präzision zu verbessern. Um die Trainingsanforderungen mehrerer Auflösungen, unterschiedlicher Seitenverhältnisse und Bildraten zu unterstützen, kann die vom Autorenteam vorgeschlagene ST-DiT-2-Architektur die Positionskodierung automatisch skalieren und Eingaben unterschiedlicher Größe verarbeiten.

1.3 Mehrstufiges Training

Im technischen Bericht heißt es, dass Open-Sora eine mehrstufige Trainingsmethode verwendet, bei der jede Stufe das Training basierend auf den Gewichten der vorherigen Stufe fortsetzt. Im Vergleich zum einstufigen Training erreicht dieses mehrstufige Training das Ziel einer qualitativ hochwertigen Videogenerierung effizienter, indem die Daten Schritt für Schritt eingeführt werden.

- Anfangsphase: Die meisten Videos verwenden eine Auflösung von 144p und werden für das Training mit Bildern und 240p- und 480p-Videos gemischt. Das Training dauert etwa eine Woche und die Gesamtschrittgröße beträgt 81 KB.

- Die zweite Stufe: Erhöhen Sie die Auflösung der meisten Videodaten auf 240p und 480p, mit einer Trainingszeit von 1 Tag und einer Schrittgröße von 22k.

- Die dritte Stufe: Weiter verbessert auf 480p und 720p, die Trainingsdauer beträgt 1 Tag und das Training mit 4.000 Schritten ist abgeschlossen. Der gesamte mehrstufige Schulungsprozess wurde in ca. 9 Tagen abgeschlossen.

Im Vergleich zu 1.0 verbessert die neueste Version die Qualität der Videogenerierung in mehreren Dimensionen.

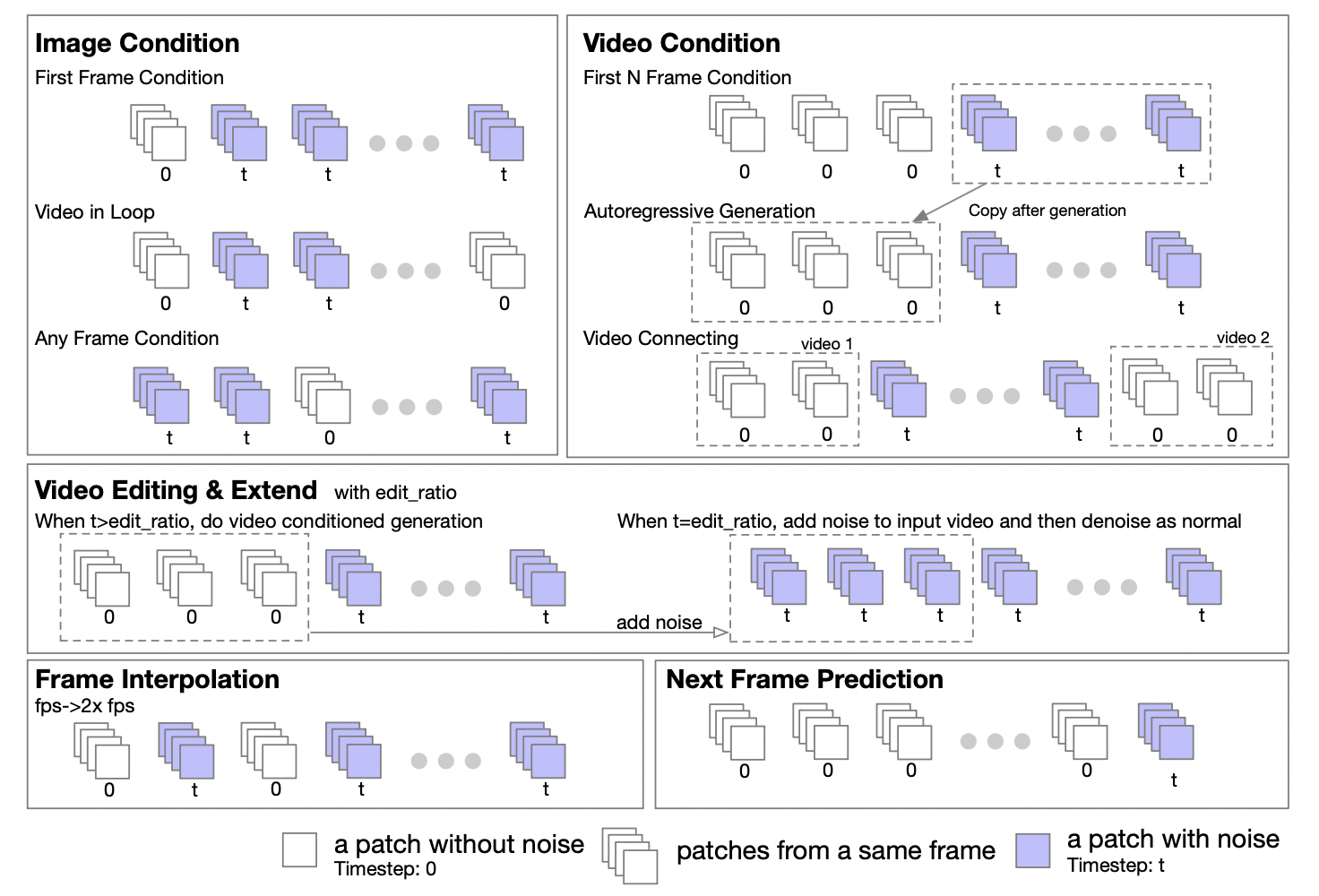

1.4 Einheitliches Rahmenwerk für bildgenerierendes Video/videogenerierendes Video

Das Autorenteam gab an, dass die DiT-Architektur basierend auf den Eigenschaften von Transformer problemlos erweitert werden kann, um Bild-zu-Bild- und Video-zu-Video-Aufgaben zu unterstützen. Sie schlugen eine Maskierungsstrategie zur Unterstützung der bedingten Verarbeitung von Bildern und Videos vor. Durch das Festlegen verschiedener Masken können verschiedene Generierungsaufgaben unterstützt werden, darunter: Grafikvideo, Loop-Video, Videoerweiterung, autoregressive Videogenerierung, Videoverbindung, Videobearbeitung, Frame-Einfügung usw.

Inspiriert von der UL2[2]-Methode führten sie in der Modelltrainingsphase eine zufällige Maskierungsstrategie ein. Konkret geht es darum, Frames während des Trainingsprozesses zufällig auszuwählen und zu demaskieren, einschließlich, aber nicht beschränkt auf, Demaskieren des ersten Frames, der ersten k Frames, der nächsten k Frames, aller k Frames usw. Der Bericht ergab auch, dass basierend auf Experimenten mit Open-Sora 1.0 das Modell bei Anwendung der Maskierungsstrategie mit einer Wahrscheinlichkeit von 50 % mit nur wenigen Schritten besser lernen kann, mit der Bildkonditionierung umzugehen. In der neuesten Version von Open-Sora haben sie eine Methode des Vortrainings von Grund auf mithilfe einer Maskierungsstrategie übernommen.

Darüber hinaus stellt das Autorenteam sorgfältig detaillierte Anleitungen zur Konfiguration der Maskierungsrichtlinie für die Inferenzphase bereit. Die Tupelform aus fünf Zahlen bietet große Flexibilität und Kontrolle bei der Definition der Maskierungsrichtlinie.

1.5 Unterstützt Multizeit-/Auflösungs-/Seitenverhältnis-/Bildratentraining

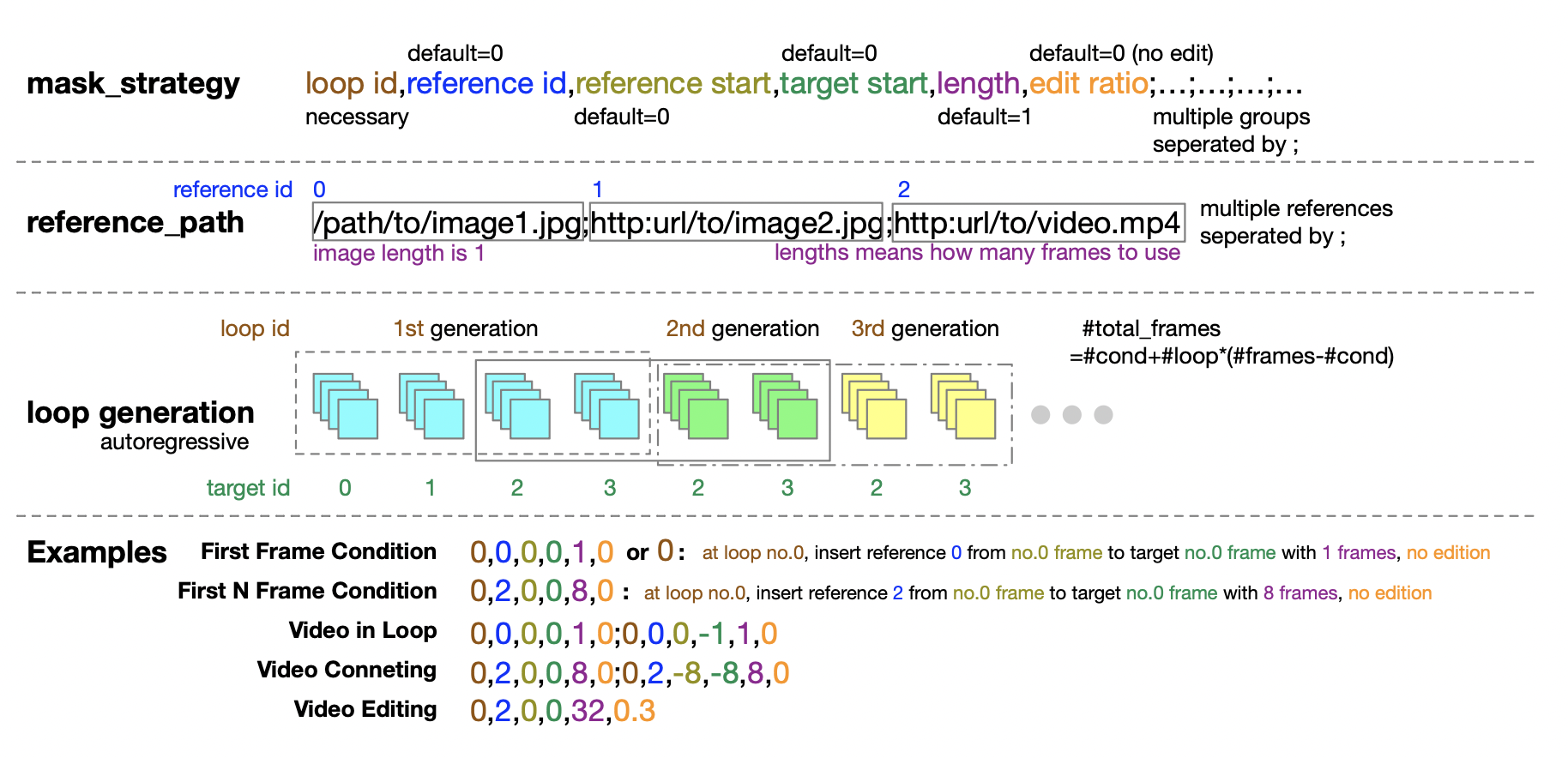

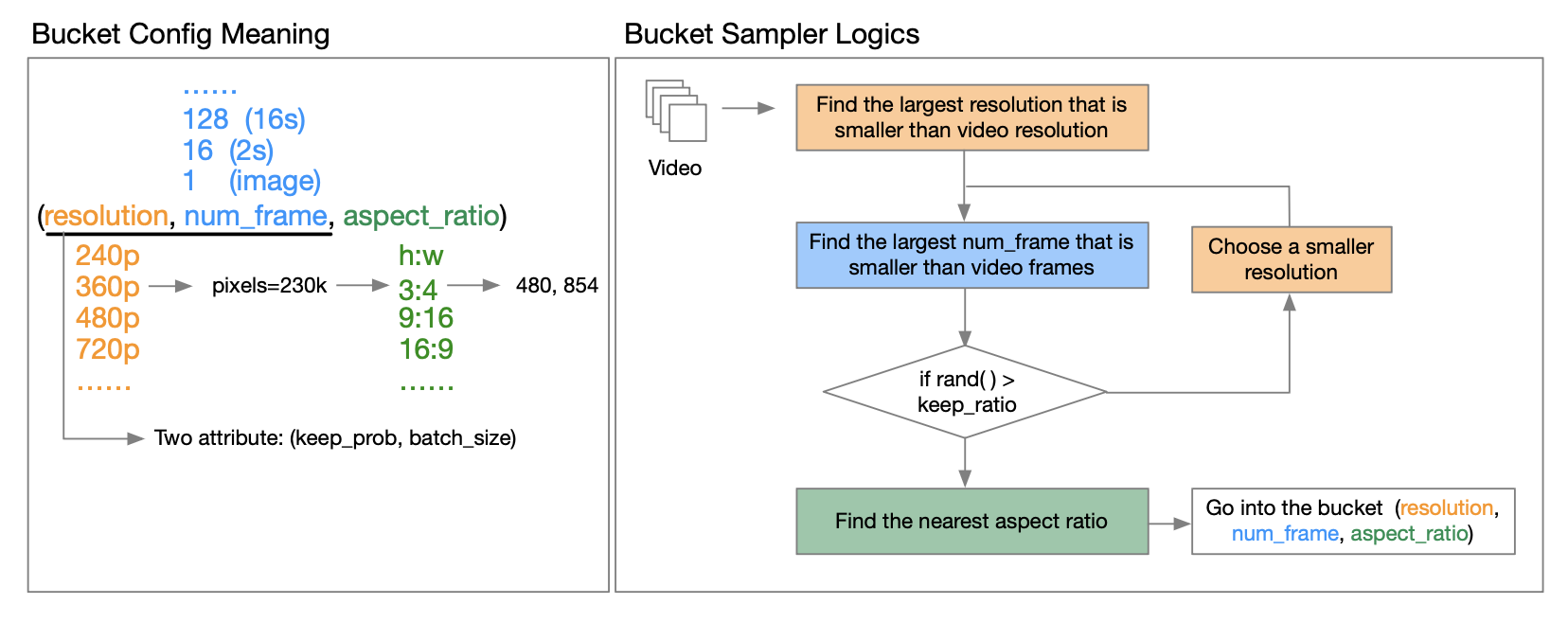

Der technische Bericht von OpenAI Sora [3] weist darauf hin, dass das Training mit der Auflösung, dem Seitenverhältnis und der Länge des Originalvideos die Sampling-Flexibilität erhöhen und Frames und Komposition verbessern kann. In diesem Zusammenhang schlug das Autorenteam eine Bucketing-Strategie vor.

Wie setzt man es konkret um? Durch eingehende Lektüre des vom Autor veröffentlichten technischen Berichts haben wir erfahren, dass der sogenannte Bucket ein Triplett aus (Auflösung, Anzahl der Bilder, Seitenverhältnis) ist. Sie definieren vorab eine Reihe von Seitenverhältnissen für Videos mit unterschiedlichen Auflösungen, um die gängigsten Arten von Video-Seitenverhältnissen abzudecken. Bevor jeder Trainingszyklus epochbeginnt, mischen sie den Datensatz neu und weisen Proben basierend auf ihren Eigenschaften den entsprechenden Buckets zu. Konkret legen sie jedes Sample in einen Bucket, dessen Auflösung und Bildlänge kleiner oder gleich dieser Videofunktion sind.

Um den Bedarf an Rechenressourcen zu reduzieren, führen sie jeweils zwei Attribute (Auflösung, Anzahl der Frames) ein, keep_probum die Rechenkosten zu senken und ein mehrstufiges Training zu ermöglichen. batch_sizeDadurch können Sie die Anzahl der Proben in verschiedenen Buckets steuern und die GPU-Last ausgleichen, indem Sie für jeden Bucket nach einer guten Batchgröße suchen. Dies wird im technischen Bericht ausführlich erläutert. Interessierte Freunde können den technischen Bericht auf GitHub lesen, um weitere Informationen zu erhalten.

GitHub-Adresse: github.com/hpcaitech/Open-Sora

1.6 Datenerfassungs- und Vorverarbeitungsprozess

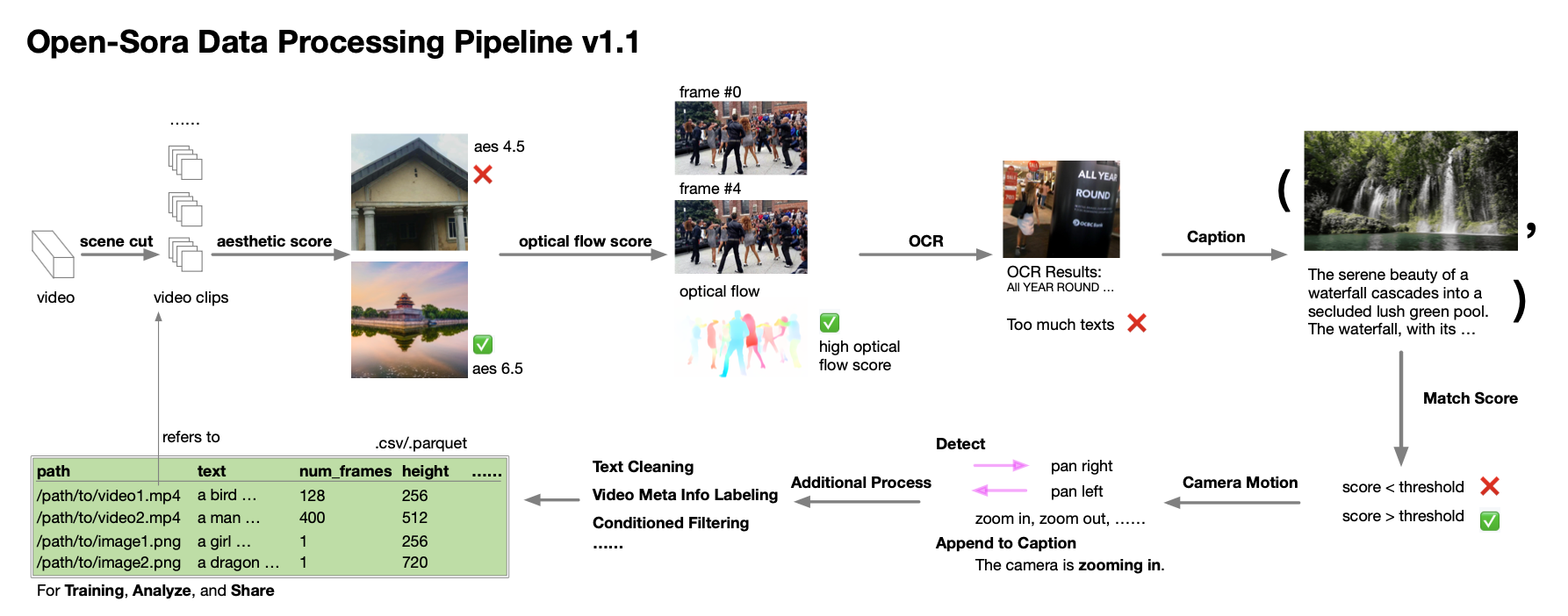

Das Autorenteam bietet sogar detaillierte Anleitungen zur Datenerhebung und -verarbeitung. Dem technischen Bericht zufolge wurde ihnen während des Entwicklungsprozesses von Open-Sora 1.0 klar, dass Quantität und Qualität der Daten für die Entwicklung eines Hochleistungsmodells äußerst wichtig sind, und so arbeiteten sie an der Erweiterung und Optimierung des Datensatzes. Sie etablierten einen automatisierten Datenverarbeitungsprozess, der dem Singular Value Decomposition (SVD)-Prinzip folgt und Szenensegmentierung, Untertitelverarbeitung, Diversitätsbewertung und -filterung sowie das Verwaltungssystem und die Spezifikation des Datensatzes umfasst.

Ebenso selbstlos geben sie Skripte zur Datenverarbeitung an die Open-Source-Community weiter. Interessierte Entwickler können diese Ressourcen nun in Kombination mit technischen Berichten und Code nutzen, um ihre eigenen Datensätze effizient zu verarbeiten und zu optimieren.

2. Umfassende Leistungsbewertung

Lassen Sie uns nach so vielen technischen Details die neuesten Videoeffekte von Open-Sora genießen und entspannen.

Das auffälligste Highlight dieses Updates von Open-Sora ist, dass es die Szene in Ihrem Kopf erfassen und durch Textbeschreibung in ein bewegendes Video umwandeln kann. Die Bilder und Vorstellungen, die Ihnen durch den Kopf schießen, können Sie nun dauerhaft aufzeichnen und mit anderen teilen. Hier hat der Autor als Ausgangspunkt verschiedene Eingabeaufforderungen ausprobiert.

2.1 Landschaft

Der Autor hat beispielsweise versucht, ein Video einer Tour in einen Winterwald zu erstellen. Nicht lange nachdem der Schnee gefallen war, waren die Kiefern mit weißem Schnee bedeckt und weiße Schneeflocken waren in klaren Schichten verstreut.

Oder Sie befinden sich in einer ruhigen Nacht in einem dunklen Wald, wie er in unzähligen Märchen beschrieben wird, und der tiefe See funkelt unter den hellen Sternen am ganzen Himmel.

Der nächtliche Blick auf die geschäftige Insel aus der Luft ist noch schöner. Die warmen gelben Lichter und das bandartige blaue Wasser lassen die Menschen sofort in die entspannte Zeit des Urlaubs eintauchen.

In der Stadt herrscht reger Verkehr, und die Hochhäuser und Straßenläden, deren Lichter bis spät in die Nacht noch brennen, haben ein ganz anderes Flair.

2.2 Natürliche Organismen

Neben Landschaften kann Open-Sora auch verschiedene natürliche Lebewesen wiederherstellen. Ob es eine kleine rote Blume ist,

Egal, ob es sich um ein Chamäleon handelt, das langsam den Kopf dreht, Open-Sora kann realistischere Videos erzeugen.

2.3 Unterschiedliche Auflösungen/Seitenverhältnisse/Dauer

Der Autor hat auch verschiedene Schnelltests durchgeführt und viele generierte Videos als Referenz bereitgestellt, darunter unterschiedliche Inhalte, unterschiedliche Auflösungen, unterschiedliche Seitenverhältnisse und unterschiedliche Dauern.

Der Autor stellte außerdem fest, dass Open-Sora mit nur einem einfachen Befehl Videoclips mit mehreren Auflösungen generieren kann und damit kreative Einschränkungen völlig durchbricht.

2.4 Tusheng-Video

Wir können Open-Sora auch mit einem statischen Bild füttern und ein kurzes Video generieren lassen.

Open-Sora kann auch zwei Standbilder geschickt verbinden. Klicken Sie auf das Video unten und erleben Sie die Veränderungen von Licht und Schatten vom Nachmittag bis zur Abenddämmerung.

2.5 Videobearbeitung

Als weiteres Beispiel möchten wir das Originalvideo bearbeiten. Mit nur einem einfachen Befehl löste der ursprünglich helle Wald heftigen Schneefall aus.

2.6 Erzeugen Sie hochauflösende Bilder

Wir können Open-Sora auch aktivieren, um hochauflösende Bilder zu generieren:

Es ist erwähnenswert, dass die Modellgewichte von Open-Sora kostenlos in der Open-Source-Community öffentlich zugänglich gemacht wurden. Da sie auch die Video-Splicing-Funktion unterstützen, haben Sie die Möglichkeit, kostenlos eine kurze Kurzgeschichte mit einer Geschichte zu erstellen, um Ihre Kreativität in die Realität umzusetzen.

Gewicht-Download-Adresse: github.com/hpcaitech/Open-Sora

3. Aktuelle Einschränkungen und Zukunftspläne

Obwohl Open-Sora bei der Reproduktion von Sora-ähnlichen Vincent-Videomodellen gute Fortschritte gemacht hat, wies das Autorenteam auch bescheiden darauf hin, dass die derzeit generierten Videos in vielen Aspekten noch verbessert werden müssen, einschließlich Rauschproblemen während des Generierungsprozesses und Zeitmangel Konsistenz, schlechte Qualität der Charaktererstellung und niedrige ästhetische Werte.

In Bezug auf diese Herausforderungen erklärte das Autorenteam, dass es der Lösung bei der Entwicklung der nächsten Version Priorität einräumen werde, um höhere Standards bei der Videogenerierung zu erreichen. Interessierte Freunde möchten möglicherweise weiterhin darauf achten. Wir freuen uns auf die nächste Überraschung, die uns die Open-Sora-Community bringt.

GitHub-Adresse: github.com/hpcaitech/Open-Sora

Verweise:

[1] https://github.com/hpcaitech/Open-Sora/blob/main/docs/report_02.md

[2] Tay, Yi et al. „Ul2: Vereinheitlichung der Paradigmen des Sprachenlernens.“ arXiv-Vorabdruck arXiv:2205.05131 (2022).

[3] https://openai.com/research/video-generation-models-as-world-simulators

Ich habe beschlossen, Open-Source-Hongmeng aufzugeben . Wang Chenglu, der Vater von Open-Source-Hongmeng: Open-Source-Hongmeng ist die einzige Architekturinnovations- Industriesoftwareveranstaltung im Bereich Basissoftware in China – OGG 1.0 wird veröffentlicht, Huawei steuert den gesamten Quellcode bei Google Reader wird vom „Code-Scheißberg“ getötet Fedora Linux 40 wird offiziell veröffentlicht Ehemaliger Microsoft-Entwickler: Windows 11-Leistung ist „lächerlich schlecht“ Ma Huateng und Zhou Hongyi geben sich die Hand, um „Groll zu beseitigen“ Namhafte Spielefirmen haben neue Vorschriften erlassen : Hochzeitsgeschenke für Mitarbeiter dürfen 100.000 Yuan nicht überschreiten Ubuntu 24.04 LTS offiziell veröffentlicht Pinduoduo wurde wegen unlauteren Wettbewerbs zu einer Entschädigung von 5 Millionen Yuan verurteilt