前言:这篇论文是2013年11月发表在CVPR上的,当时正值卷积神经网络在计算机视觉任务中初放光彩。17年刚刚接触深度学习的时候看过这篇论文,当时也是在组会上讲过。以下就是大概的讲解思路。但是当时看这篇论文没有太大的感觉,觉得这篇论文只是做了一个非常简单的事情,所以主要是从宏观上说明了一下可视化卷积神经网络的作用。前两天偶然翻出来这篇论文,却觉得论文里有些地方挺有意思的,果然论文和人颇有相似,讲究的是对的时间遇到对的人。这里先把当时讲的一些要点摘抄过来,有时间回看一遍,再做整理。

这篇论文的主要思路是: 将产生的特征通过反卷积技术,重构出对应的输入刺激,而重构的刺激只会显示真正有用东西,作者就可以通过分析这些信息来分析模型,实现模型调优。

论文背景介绍

神经网络发展很迅速, 尤其是卷积神经网络在图像处理方面发挥了很大的作用,当输入一张图片到卷积网中时,网络会逐级产生特征,但究竟是图片中的哪一部分刺激网络产生了特定特征,没法直接得到。一般来说,卷积第一层还可以大概看到图像的特征,但是随着卷积层数的加深,卷积出来的图像已经面目全非了。

这篇论文就是通过反卷积技术,让深层次的神经网络也能展示出来他的特征。

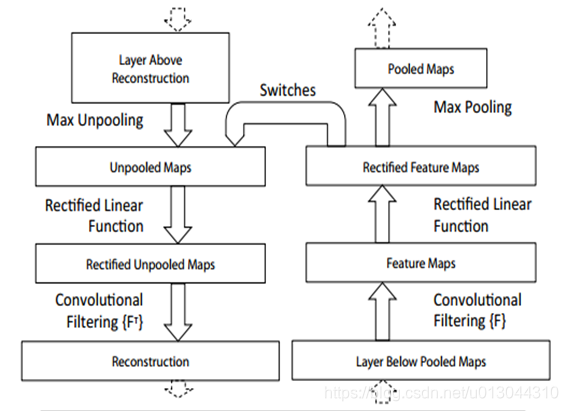

具体的流程如下图:

可视化卷积神经网络的用处

至此,这篇论文里的关键技术难点已经讲完了,作者提出来这个反卷积,主要是用来干什么呢?

作者主要用反卷积做出了以下几个结果。

-

当然就是最主要的目的: 特征的可视化。他把每层的图像都反卷积出来, 然后观察, 发现:

1)每组重构特征都有很强的关联性。

2)层次越高,特征越稳定。第一层只学到了边缘。第二层学到了稍微复杂的图案, 比如说圆形, 丁字形, 角度, 曲线等。第三层开始学到一个具体纹理。第四层甚至最高层学到了更加完整的特征, 比如说狗脸, 人脸等。

3)图像中关键的特征被夸大 -

作者还研究了特征在训练过程中的演化。 在训练过程中, 作者从把每一层的输出特征反向卷积,可以发现, 在迭代开始的时候,每一层都发生很大的变化,但是经过一定的迭代次数,低层首先区域稳定,高层需要更多的迭代次数才能区域稳定。

这也表明了, 只有所有层都收敛时, 分类模型才能用。 -

特征不变性。也就是说把图片进行平移,旋转,缩放。观察不同层的特征不变性能力。可以看到, 在第一层, 很小的变化都会导致其明显的变化, 层数越高, 平移和缩放对最终结果的影响比较小。总体来说, 卷积网无法对旋转操作产生不变性,除非物体本身具有很强的对称性。

-

结构的优化.第一层混合了大量的高频和低频信息, 缺少中频信息, 第二层产生了混乱无用的特征。新的模型不但保留了一二层绝大部分有用的特征, 还提高了最终的分类性能。

-

遮挡敏感性。分类器到底使用了什么信息实现分类? 是图像中具体位置的像素值, 还是图像的背景?为了回答这个问题, 作者使用了一个灰色的矩形对输入图像的每个部分进行遮挡, 并测试在不同遮挡情况下, 分类器的输出结果。可以看到当关键区域发生遮挡时, 分类器的性能急剧下降。 而且当遮挡发生在关键物体的位置时, 响应强度急剧下降。另外,用这种方法可以找出途中哪部分的特征是最关键的。在第五层的时候, 遮挡眼睛和鼻子等部位会使识别率更低, 但是在第七层的时候, 随机遮挡图片和遮挡眼睛、 鼻子等部位都是一样的。 作者猜想可能是更高层更关注狗的品种等更深层次的问题。

总结:

这篇论文最重要的贡献是提出了反卷积的这个概念, 直观展示了 CNN 如何工作, 这些可视

化技术不仅描述了 CNN 内部的工作原理,同时对神经网络结构的优化提供了深刻的见解。

除此之外, 反卷积除了用于可视化之外,后来的学者还利用反卷积做了:

1) 图片的无监督学习

2) FCN 网络中的上采样

3) GAN 中的图片生成。