版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/LawGeorge/article/details/79548548

学习机器学习算法之决策树,这个大侠的文章写得不错:http://www.cnblogs.com/yonghao/p/5061873.html

总结一下:

1.对于信息熵的理解:

选假设有一个离散型随机变量X有4中可能的结果:A-1/2,B-1/4,C-1/8,D-1/8,后面的是每种结果的发生概率。那么如果顺序的去猜测X,就会有以下事件可能发生:问到A,命中A,用一次,问A->B,命中B,用两次,问A->B->C,命中C,用三次,问A->B->C,不命中C但是只剩下D自然就会命中D,用三次,所以平均次数=1/2×1+1/4×2+1/8×3+1/8×3=1/2×log2(2)+1/4*log2(4)+1/8*log2(8)+1/8*log2(8)=1.75bit。说明用计算机对X的取值编码的平均长度为1.75个bit(这里引用知乎回答,可以比较形象体会一下信息的量化)。在获得随机变量后会得到信息,那么定义这信息增益量为:log(pi^-1),即对应概率的倒数的对数。总的来说,信息熵是用来刻画数据集合复杂度的统计量,信息熵越大越复杂越没有达到分类的目的,数据集就越不纯。注意在公式中的对数的底数取值可以有不同,一般取2单位是bit,也有取e的单位信息单位奈特nat,只要>1就可以。

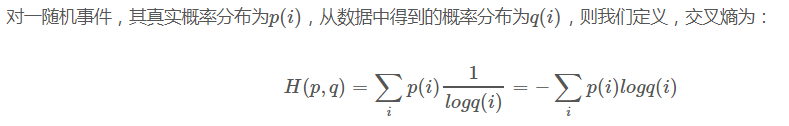

2.交叉熵:

描述两个数据集合相似程度的度量方法。用交叉熵代替成本函数,通过量化正确结果集与预测结果集的相似程度及交叉熵,就可以快速下降。