2.1 标量、向量、矩阵和张量

标量:scalar,是一个单独的数

向量:vector,是一列有序的数.方括号包围的纵列,每个元素有一个索引。

矩阵:matrix,二维数组,每个元素由两个索引组成。Aij处于i行j列。

张量:tensor,超过二维的数组。

标量和矩阵的运算:

![]()

向量和矩阵的运算:将向量隐式的复制到很多位置的方式成为广播(broadcasting)

![]()

2.2 矩阵和向量相乘

矩阵A、B、C有C=AB,

A(m*n)、B(n*p),则C(m*p)

矩阵乘积满足分配律A*(B+C)=A*B+A*C

结合律A*(B*C)=A*B*C

但是不满足交换律A*B≠B*A

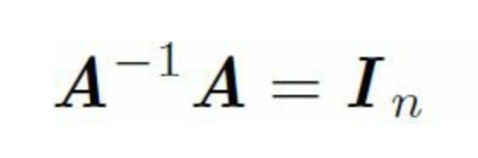

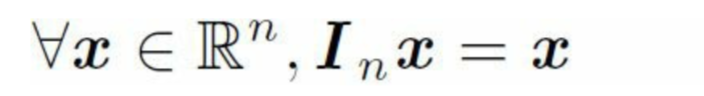

2.3 单位矩阵和逆矩阵

单位矩阵In(identity matrix),沿主对角线元素是1,其余位置元素都是0.

矩阵和它的逆矩阵相乘得到单位矩阵。

一个n维向量x和单位矩阵的乘积还是它本身x。

2.4 线性相关和生成子空间

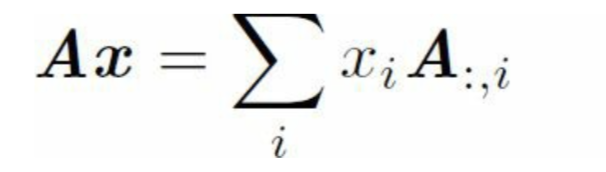

A是矩阵,x是列 向量。对于Ax=b,(A:m*n, x:n维空间, b:m维空间)如果有解,向量的线性组合。如果要让Ax=b有解,n≥m

加入A是一个3*2的矩阵 ,目标 b是3维的,而x只有2维,那么只能得到三维空间的一个 二维平面,当且仅当b在这个二维平面上时,该方程有解。

n≥m是必要条件,但不是充分条件,因为有的列向量是冗余的,(如果两个列向量相同,那么他们表示的矩阵列空间是一样的,这种冗余称为线性 相关)。如果一组向量中的任何一个列向量都不能表示成其他列向量的线性组合,就称这组向量称为线性无关。那么,如果一个矩阵的列空间涵盖Rm,那么它至少有m个线性无关的列向量。

一组向量的生成子空间span,是原始向量线性组合后能抵达点的组合 。

矩阵可逆的条件:矩阵必须是一个方阵,m=n,所有列向量都是线性无关的。

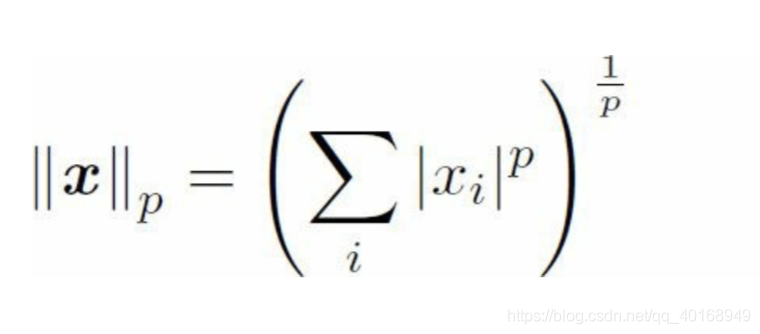

2.5 范数 norm

机器学习中用范数来衡量向量的大小

2范数又称欧几里得范数,表示原点到向量的距离。倒数与整个向量有关,但是在原点附近增长缓慢。在机器学习 应用中,区分 恰好是零和零附近很小的元素是很重要的,这时候1范数比较好用--斜率相同,与x增长速度相同。

有时候用非零元素的个数衡量向量的大小,因为非零元素缩放a倍并不会改变非零元素数目,因此常用1范数表示非零元素数目的替代函数。

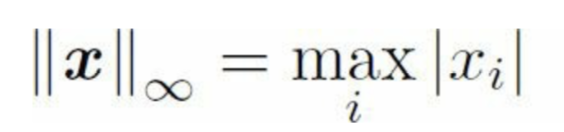

最大范数(max norm)表示向量中具有最大幅度的元素绝对值。

frobenius norm:针对矩阵而言 ,类比二范数。

2.6 特殊类型的矩阵和向量

对角矩阵(diagonal matrix)只有主对角线元素非零,区分于单位矩阵--对角线元素全1,其他位置全0.

并非所有对角矩阵都是方阵,非方阵的对角矩阵不存在逆矩阵。

对称(symmetric)是矩阵转制和自己相等的矩阵。某些不依赖参数顺序的双参数函数 生成元素时,会出现对称矩阵,Aij=Aji.

2.7 特征分解

将矩阵分解成一组特定的向量和特征值。