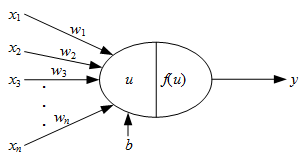

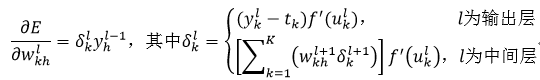

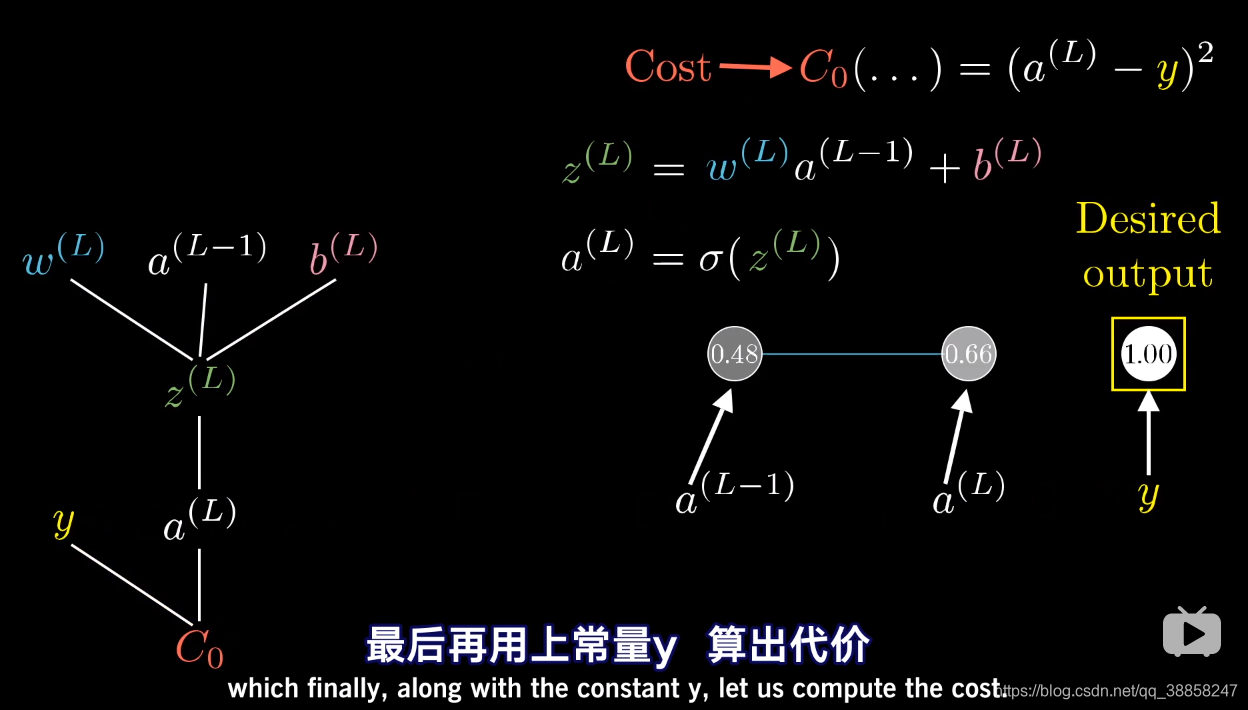

神经元内部包括两个部分,第一个部分是对输入的加权求和,第二个部分是对求和的结果进行“激活”

https://blog.csdn.net/App_12062011/article/details/53420510

这里的o 激活函数:sigmoid ReLU

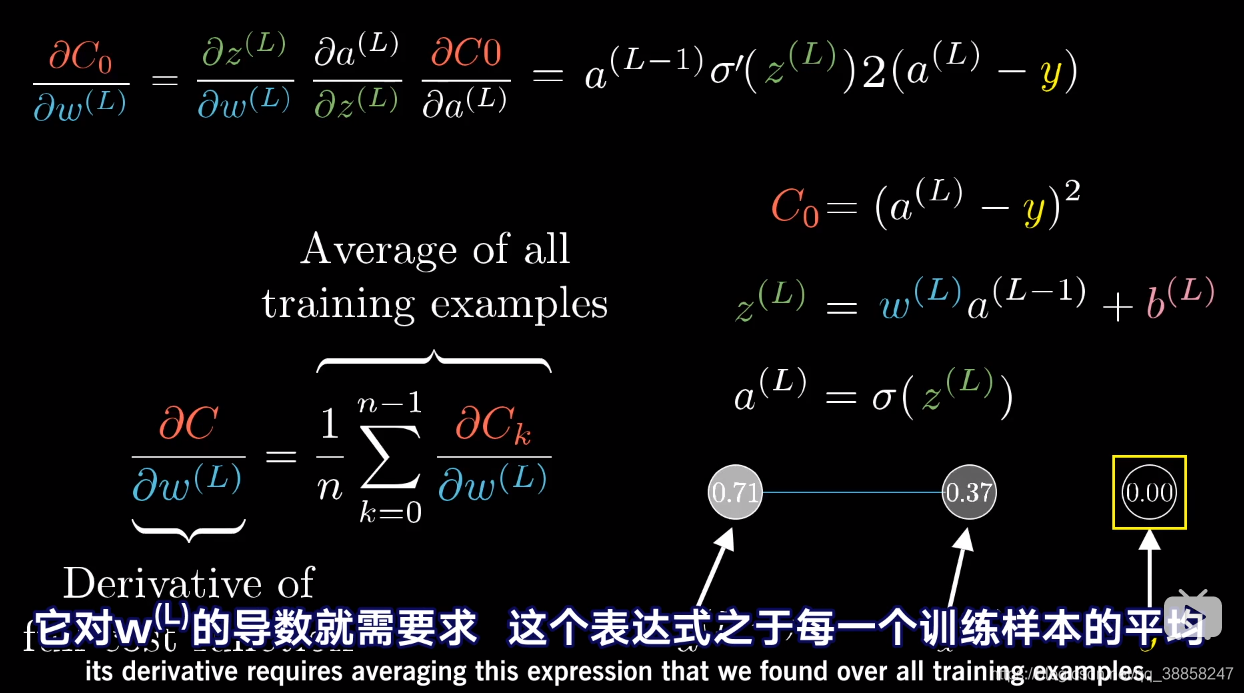

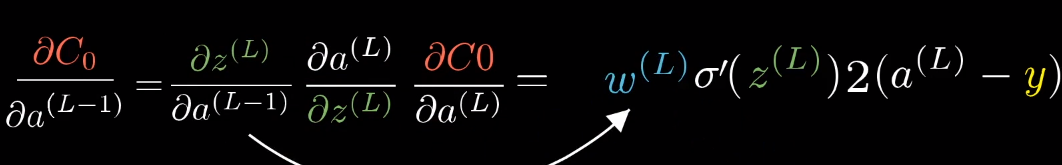

see how sensitive this cost func(代价函数) is to the activation of the previous layer ![]()

初始化权值:

一般的做法是随机选择很小的值作为初始权值,但这样做收敛较慢

Nguyen-Widrow算法:

基本思想是每个神经元都有属于自己的一个区间范围,通过初始化权值就可以限制它的区间位置,当改变权值时,该神经元也只是在自己的区间范围内变化,因此该方法可以大大提高收敛速度

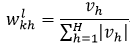

对于所有连接输出层的权值和偏移量,初始值为一个在正负1之间的随机数。对于中间层的权值,初始为:

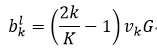

式中,vh是一个在正负1之间的随机数,H为第l-1层神经元的数量。而中间层的偏移量初始为:

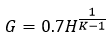

式中,vk是一个在正负1之间的随机数,K为第l层神经元的数量,而G为:

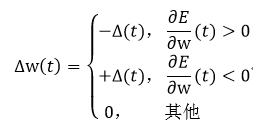

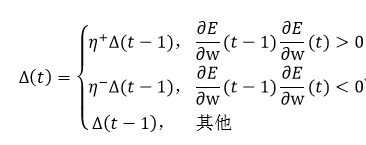

Backprop算法有一些不足之处。首先是它的学习效率η是需要我们事先确定好;另外权值的变化是基于误差梯度的变化率,虽然这点乍一看,似乎没有问题,但我们不敢保证它永远正确有效。为此Riedmiller等人提出了RPROP算法(resilient backpropagation),用以改善Backprop算法

式中,常数η+必须大于1,常数η-必须在0和1之间

Δ(0)初始化为0.1是比较正确的选择,而Δmax(t)=50,Δmin(t)=10-6可以有效的防止溢出