传统的神经网络去噪方法,一般以带有噪声的图片作为输入,清晰的图片作为输出,在这基础上训练神经网络以拟合两者之间的映射,从而实现去噪功能。样本对 (x^i,yi) ( x ^ i , y i ) 中, xi x i 作为带噪声的输入图片, yi y i 作为应当输出的清晰图片,然后最小化经验风险

argmin∑L(fθ(x^i),yi)(1) (1) a r g m i n ∑ L ( f θ ( x ^ i ) , y i )

考虑到分别获取带噪声图片和清晰图片的成本比较高昂,Noise2Noise描述了一个只使用带噪声的图片作为训练样本以实现去噪功能的方法。既然没有带噪声图片与清晰图片相互对比,那么神经网络就要把带噪声的图片和没有观察到的清晰图片建立联系。

假设 (y1,y2,…) ( y 1 , y 2 , … ) 是室温的测量数据,一般估计室温 z z 的方法是

对于 L2 L 2 损失 L(z,y)=(z−y)2 L ( z , y ) = ( z − y ) 2 ,有

z=Ey{

y}(3) (3) z = E y { y }

神经网络拟合是一种点估计方法,对于输入输出对 (xi,yi) ( x i , y i ) ,有

argminθE(x,y){

L(fθ(x),y)}(4) (4) a r g m i n θ E ( x , y ) { L ( f θ ( x ) , y ) }

若 y y 与 独立,则这个问题弱化为 (2) ( 2 ) ,但是实际上并不是,则有

argminθEx{

Ey|x{

L(fθ(x),y)}}(5) (5) a r g m i n θ E x { E y | x { L ( f θ ( x ) , y ) } }

可看成在每个输入数据之下求解点估计问题。

实际上,有的输入输出数据并不是 1:1 1 : 1 映射,而是多值映射,例如超分辨率问题中一个低分辨率 x x 有多个高分辨率的 与之对应,所以 p(y|x) p ( y | x ) 的分布比较复杂。所以使用 L2 L 2 损失时,以低分辨率图片 x x 作为输入,高分辨率图片 作为输出,这时作为神经网络的 fθ f θ 输出的结果是所有可能的高分辨率输出的平均,这样的图片局部空间细节是模糊的,达不到想要的结果,当然这时可以使用一个训练过的判别器作为损失。

若将 y y 替换成另外一个随机数据 ,但是其期望和原有的 y y 的期望一样,那么 中求解的结果依然不变。进一步来说,若将 p(y|x) p ( y | x ) 替换成其它的任意分布,但是条件期望保持不变,这时 (5) ( 5 ) 求出的结果也依然不变。所以对 y y 添加一个均值为 的噪声扰动产生 y^ y ^ ,把 y y 替换成 后对 fθ f θ 进行训练,这时 fθ f θ 的训练结果依然不变,则求解的问题变成

argminθ∑iL(fθ(x^i),y^i)(6) (6) a r g m i n θ ∑ i L ( f θ ( x ^ i ) , y ^ i )

这时 x^ x ^ 和 y^ y ^ 都来自于受噪声扰动的分布(这两者不必是同一个分布),但是要求 E{ y^i|x^i}=yi E { y ^ i | x ^ i } = y i 。若有无限数据, (6) ( 6 ) 和 (1) ( 1 ) 的结果是一样的,若只有有限数据,则估计的方差是 y^ y ^ 的噪声方差除以样本数。对于一般去噪问题来说,即使图片样本数量不多,但是受益于图片自身具有的邻域不变性,实际起作用的样本数依然较大。

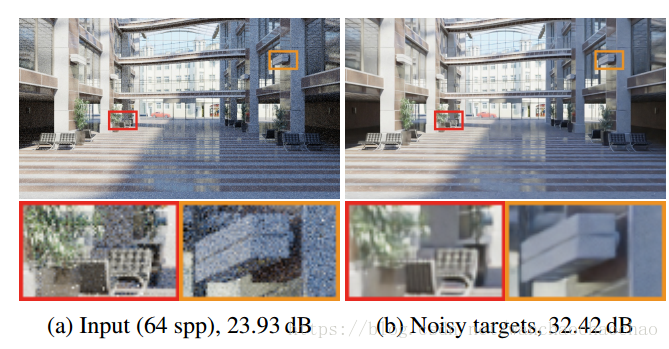

而在许多图像复原问题中,输入的噪声数据的期望都正好是我们所要复原的数据。例如,对于微光拍摄来说,一个长曝光无噪声的图片正好就是各自独立的、短曝光的、带噪声的图片的平均。以上的发现说明,我们只要有两张带噪声但内容一样的图片作为训练样本,就能实现和原来一样的去噪功能,这样比原来获取清晰图片所需的成本小多了。

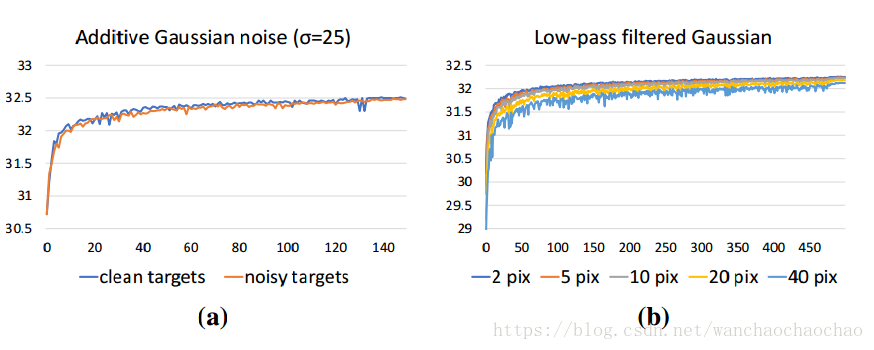

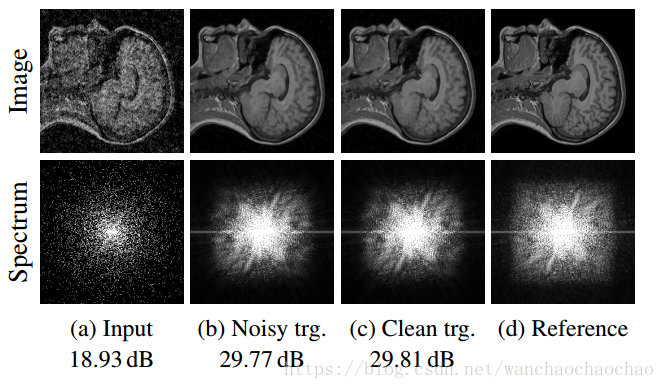

从实验结果图中可以看到,和原来使用清晰图片的方法相比收敛速度差不多

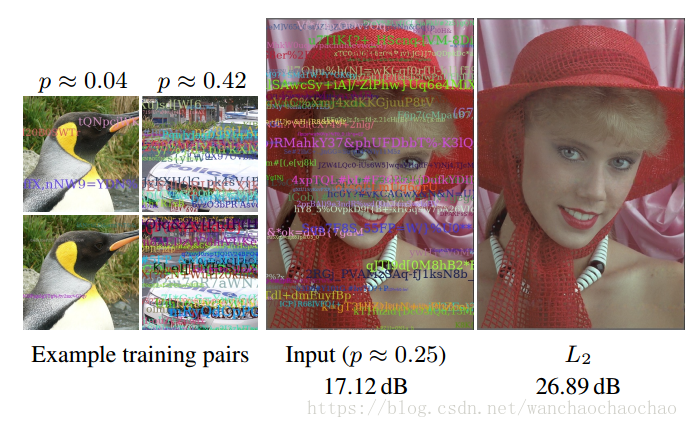

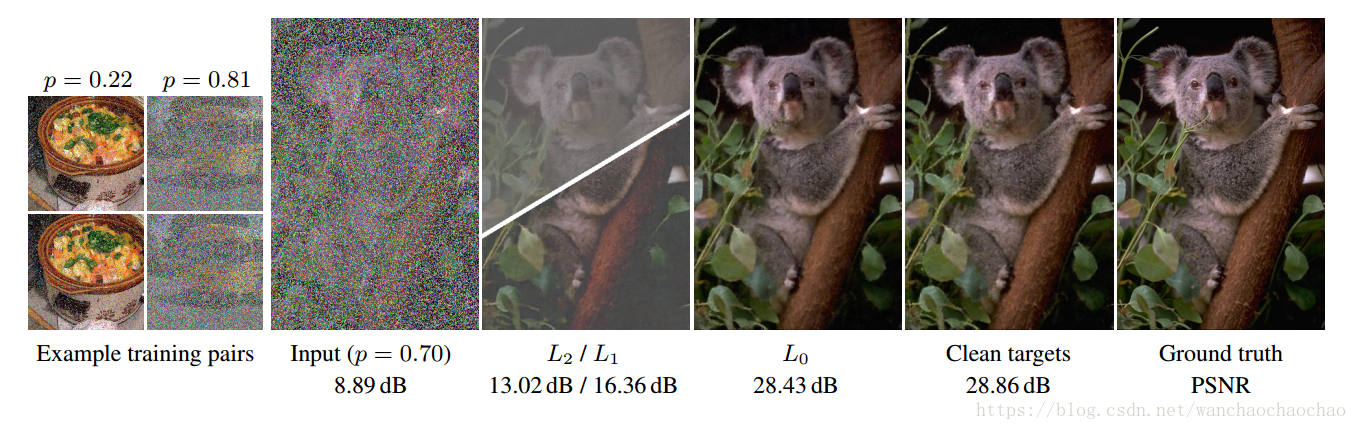

文中给出了各种噪声的实验,如高斯噪声、泊松噪声、多元伯努利噪声、弹幕文本噪声等,还有动态自适应、医学MRI去噪等问题,对于不同的噪声,使用的损失也不一样。如弹幕文本噪声,使用 L2 L 2 损失是不对的,因为覆盖的文本噪声具有与原始图片无关的颜色,而这会导致最终结果是原始图片与弹幕文本颜色均值的线性组合,然而一般来说,虽然有弹幕文本遮挡,但是每个像素在大部分时间里都保持原有颜色,所以中位数是一个好的统计量,这里应该使用的损失是 L1=|fθ(x^)−y^| L 1 = | f θ ( x ^ ) − y ^ | 。

论文地址