Canal解析MySQL 5.7的binlog

https://github.com/alibaba/canal

1.配置Linux的yum源

1.0删除老版本的MySQL

yum remove mysql mysql-serverrm -rf /var/lib/mysql 1.1在命令行中执行如下的命令,添加MySQL5.7的yum源

cat >> /etc/yum.repos.d/mysql57.repo << EOF[mysql57-community]name=MySQL 5.7 Community Serverbaseurl=http://repo.mysql.com/yum/mysql-5.7-community/el/6/\$basearch/enabled=1gpgcheck=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-mysqlEOF1.2 执行安装MySQL的命令(用root用户安装,普通用户使用sudo)

yum install -y mysql-community-server2.启动MySQL服务

service mysqld start3.修改MySQL密码

3.1获取MySQL临时密码

grep 'temporary password' /var/log/mysqld.log3.2使用临时密码登录MySQL

mysql -uroot -p-yuysJYN?0ul3.3修改MySQL密码

修改密码的安全级别(生产环境不用修改)

set global validate_password_policy=LOW;set global validate_password_length=6;ALTER USER 'root'@'localhost' IDENTIFIED BY '123456';4.添加一个普通用户

4.1 创建一个普通用户

CREATE USER canal IDENTIFIED BY 'canal123'; 4.2赋予权限

GRANT SELECT, REPLICATION SLAVE, REPLICATION CLIENT ON *.* TO 'canal'@'%';4.3刷新权限

FLUSH PRIVILEGES;5 创建一个数据库

CREATE DATABASE doit CHARSET utf8;6 修改MySQL的配置

canal的原理是基于mysql binlog技术,所以这里一定需要开启mysql的binlog写入功能,建议配置binlog模式为row

修改MySQL配置文件

vi /etc/my.cnf- 一定要配置mysql的biglog模式为ROW

[mysqld]log-bin=mysql-bin #添加这一行就okbinlog-format=ROW #选择row模式server_id=1 #配置mysql replaction需要定义,不能和canal的slaveId重复重启mysql

service mysqld restart7安装Canal的

7.1 下载Cannal 1.1.3版本(canal.deployer-1.1.3.tar.gz)

https://github.com/alibaba/canal/releases7.2上传到MySQL所在的机器上,然后解压

mkdir -p /bigdata/canaltar -zxvf canal.deployer-1.1.3.tar.gz -C /bigdata/canal/8.修改Canal的配置文件

- 需求:将MySQL的binlog数据采集后发生到Kafka中

8.1修改canal的主配置文件

cd /bigdata/canal/vi canal.properties#canal跟kafka整合,将数据发送到kafkacanal.serverMode = kafka#指定kafka broker地址canal.mq.servers = node-1.51doit.cn:9092,node-2.51doit.cn:9092,node-3.51doit.cn:9092#数据发送kafka失败重试次数canal.mq.retries = 108.2修改canal的实例配置文件

vi conf/example/instance.properties

#mysql数据库的地址canal.instance.master.address=127.0.0.1:3306#mysql用户名canal.instance.dbUsername=canal#mysql密码canal.instance.dbPassword=canal123#注释掉使用默认的topic(将数据写入到默认的Topic)#canal.mq.topic=example# dynamic topic route by schema or table regex#使用动态topic,将doit的数据库的test表发送到kafka的test1的topic#将doit的数据库的user表发送到kafka的user1的topiccanal.mq.dynamicTopic=test1:doit\\.test,user1:doit\\.user8.3启动Canal

bin/startup.shhttps://github.com/alibaba/canal/wiki/AdminGuide

mysqladmin -uroot -pDoIt123 password 123456

GRANT ALL PRIVILEGES ON hivedb.* TO 'hive'@'%' IDENTIFIED BY '123456' WITH GRANT OPTION;GRANT ALL PRIVILEGES ON *.* TO 'root'@'%' IDENTIFIED BY '123456' WITH GRANT OPTION;FLUSH PRIVILEGES;开启Kafka消费者

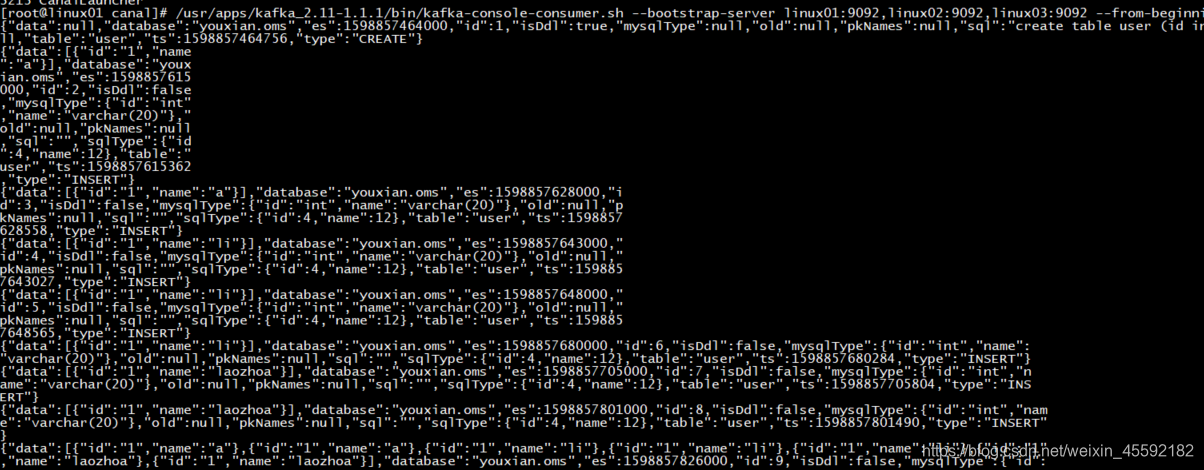

/usr/apps/kafka_2.11-1.1.1/bin/kafka-console-consumer.sh --bootstrap-server linux01:9092,linux02:9092,linux03:9092 --from-beginning --topic example

登录Mysql

启动mysql

service mysqld start

mysql -uroot -p123456

建表:

create table user (id int , name varchar(20) );

插入数据

insert into user values (1 , "a");

insert into user values (1 , "li");

接收到的数据

说明部署成功。。。