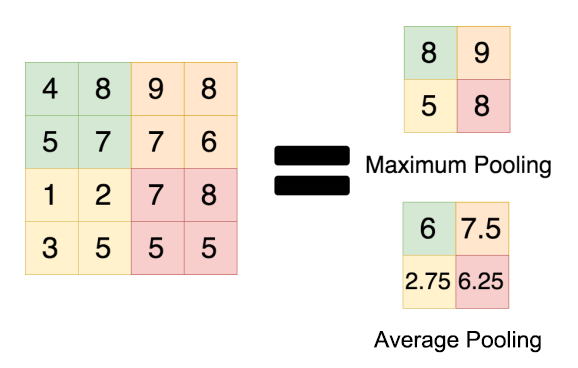

在训练卷积神经网络模型时,经常遇到max pooling 和 average pooling,近些年的图像分类模型多数采用了max pooling,为什么都是使用max pooling,它的优势在哪呢?

一般情况下,max pooling的效果更好,虽然 max pooling 和 average pooling 都对数据做了sampling,但是感觉max pooling更像是做了特征选择,选出了分类辨识度更高的特征,提供了非线性,根据相关理论,特征提取的误差主要来自两个方面:(1)邻域大小受限造成的估计值方差增大;(2)卷积层参数误差造成估计均值的偏移。一般来说,average pooling 能减小第一种误差,更多地保留图像的背景信息,max pooling 能减小第二种误差,更多地保留纹理信息。average pooling 更侧重对整体特征信息进行sampling,在减少参数维度方面的贡献更大一些,更多地体现在信息的完整传递这个层面上,在一个很大很有代表性的模型中,比如DenseNet中的模块之间的连接大多采用 average pooling,在减少维度的同时,更有利信息传递到下一个模块进行特征提取。

average pooling 在全局平均池化操作中应用得也比较广,在ResNet和Inception结构中最后一层都使用了平均池化。有的时候,在接近模型分类器的末端使用全局平均池化还可以代替flatten操作,使输入数据变成一维向量。

max pooling 和 average pooling 的使用性能对于设计卷积网络模型还是很有帮助的,虽然池化操作对于整体的精度提升效果不大,但是在减参降维,控制过拟合以及提高模型性能,节约算力方面的作用还是很明显的,所以池化操作是卷积神经网络设计上不可缺少的一个环节。