目录

一、文章简介

作者认为现有的研究关系的方法大多是单个视觉区域和单词之间的模型关系,这不足以正确回答这个问题。但从人类的角度来看,回答视觉问题需要理解视觉和语言信息的概要。本文提出了多模态潜交互模块(MLI)来解决这一问题。该模块学习潜在的视觉和语言概要之间的跨模态关系,其中将视觉区域和问题归纳为少量的潜在表征,以避免建模无信息单个视觉-问题关系。潜在的概要之间的跨模态信息被传播以从两种模态中融合有价值的信息,并且用于更新视觉和文字特征。这样的MLI模块可以被堆叠以建模两种模态之间的复杂和潜在关系。

二、模型概要

MLI模块首先将问题和图像特征编码成少量潜在的视觉和问题概要向量( summarization vectors)。每个概要向量都可以表示为视觉或文字特征的加权合并,其从全局角度概括每个模态的某些方面,因此与单个单词和区域特征相比,编码更丰富的信息。在获得每种模态的概要之后,我们在多模态概要向量之间建立视觉语言关联,并提出在概要向量之间传播信息去模拟语言与视觉之间复杂的关系。每个原始视觉区域和单词特征将从更新的潜在概要中聚合信息,然后使用注意力机制和残差连接来预测正确答案。

三、多模态潜在交互网络模型

上图展示了Multi-modality Latent Interaction Network(MLIN)的模型结构,它由多个MLN模块堆叠而成。其目的是将输入的视觉区域和问题特征概括为每个模态的少量潜在概要向量。核心思想是将视觉信息和问题信息传播到潜在的概要向量中,从全局的角度对复杂的跨模态交互进行建模。在潜在交互概要向量之间的信息传播之后,可视区域和单词特征将来自跨区域的概要信息进行聚合以更新其特性。MLI模块的输入和输出具有相同的尺寸,整个网络由多个MLI模块堆叠而成,以逐步细化视觉和语言特征。在最后阶段,我们对视觉区域的平均特征和问句进行元素乘法,以预测最终答案。

3.1.问题与视觉特征编码

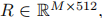

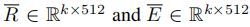

对于输入图像I,我们使用Faster RCNN目标检测器提取视觉区域特征,每张图片被编码为M个视觉区域特征,表示为

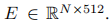

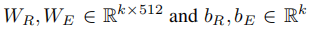

对于输入问题Q,将句子将填充到最大长度为14,并由具有随机初始化的双向Transformer编码,表示为 多模态特征编码可以表述为:

多模态特征编码可以表述为:

3.2. Modality Summarizations in MLI Module

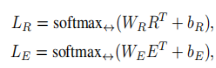

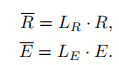

在获取视觉特征和问题特征后,我们添加了一个轻量级的神经网络,为每个模态生成k组潜在的视觉或语言概要向量。首先通过K组线性组合权重 ,其中

,其中 是每个模态的k组可学习的线性变换权重,

是每个模态的k组可学习的线性变换权重, 表示沿水平维的Softmax操作,这里用水平的原因我想可能是WRRT∈Rk*m,共有k行m列,沿水平方向进行softmax操作,共执行k次,每一次操作包含m个区域的信息,实现不同区域的交互,softmax函数的返回结果和输入的tensor有相同的shape。然后可以将各个视觉和问题特征R和E转换为K个潜在的概要向量

表示沿水平维的Softmax操作,这里用水平的原因我想可能是WRRT∈Rk*m,共有k行m列,沿水平方向进行softmax操作,共执行k次,每一次操作包含m个区域的信息,实现不同区域的交互,softmax函数的返回结果和输入的tensor有相同的shape。然后可以将各个视觉和问题特征R和E转换为K个潜在的概要向量 ,公式如下:

,公式如下:

k个潜在的视觉或语言概要向量中的每一个(即R或E的每一行)都是输入单个特征的线性组合,每个模态中的k个概要向量可以从全局角度捕捉输入特征的k个不同方面信息。

3.3. Relational Learning on Multi-modality Latent

3.3.1 Relational Latent Summarizations

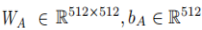

所获得的潜在概要向量编码了每个模态的高级信息。为了给出与输入图像和问题相对应的正确答案,理解输入之间复杂的跨域关系是非常重要的。因此,利用一个关系学习网络来建立跨领域的关联。引入上述每个模态的k个潜在概要向量 并创建创建了K×k个潜在的视觉问题特征对,这样的k×k对可以表示为三维关系张量A∈Rk×k×512:

并创建创建了K×k个潜在的视觉问题特征对,这样的k×k对可以表示为三维关系张量A∈Rk×k×512:

这里少了转置符号, 表示元素态乘法,

表示元素态乘法, ,结果是1×512维的,然后用WA乘,得到512*1的向量

,结果是1×512维的,然后用WA乘,得到512*1的向量

3.3.2 Relational Modeling and Propagation

在这两种模式中传播信息对于学习复杂的答案预测关系是很重要的,基于我们的跨模态关系张量A,我们引入了两个在配对特征之间传递和聚集信息的操作。在信息传播之前,先将张量A∈Rk×k×512的维度转换为 。

。

第一个跨模态消息传递操作:对每个配对特征执行额外的线性转换

,其中

,其中 是将每个配对特征A(i,j,:)转换成一个新的512维特征的关系线性变换参数

是将每个配对特征A(i,j,:)转换成一个新的512维特征的关系线性变换参数

第二个跨模态信息传播操作:执行在不同配对特征之间传递的信息

是通过成对的特征传播信息的线性变换参数

是通过成对的特征传播信息的线性变换参数

两个跨模态转换的结果针对在跨模态配对特征的不同方面,模拟输入图像和问题之间的复杂关系。第一操作集中于建模每个单独的视觉问题潜在对之间的关系,而第二操作尝试在所有视觉问题对之间传播高阶信息以模型更复杂的关系。

最后对上述两个操作结果进行求和, 可以被认为是对两种模态中的潜在概要向量之间的跨域关系进行深度编码的潜在表示。

可以被认为是对两种模态中的潜在概要向量之间的跨域关系进行深度编码的潜在表示。

3.3.3 Relational Modeling and Propagation

【这里图上的Q,K位置写反了】

【这里图上的Q,K位置写反了】

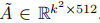

潜在多模态表示 包含融合的问题和区域特征。每个原始的视觉特征R(I,:)和词特征E(I,:)都可以从潜在的表征Aˆ中聚合信息,提高它们的特征识别性,这对最终的VQA精度产生了最重要的影响。特征聚合过程可以由Transformer的keyquery注意机制来建模。

包含融合的问题和区域特征。每个原始的视觉特征R(I,:)和词特征E(I,:)都可以从潜在的表征Aˆ中聚合信息,提高它们的特征识别性,这对最终的VQA精度产生了最重要的影响。特征聚合过程可以由Transformer的keyquery注意机制来建模。

每个区域和单词特征 转换为128维查询(query)向量,

转换为128维查询(query)向量,

潜表示的每个特征Aˆ转换为128维键(key)和值(value)向量

区域的查询特征个单词特征将对来自潜在表示的不同关键特征K进行加权,公式如下。

其中 表示沿垂直方向进行softmax操作,dim=128是归一化常数,

表示沿垂直方向进行softmax操作,dim=128是归一化常数,

原始区域和单词的特征可以更新为:

输入特征R,E和输出特征RU,EU具有相同的维度,我们进行多个MLN堆叠进行不断地细化视觉和语言特征,最后,我们对视觉区域特征和单词特征进行平均池化,并对池化后的两种特征进行元素乘操作,最后,采用具有SoftMax非线性函数的线性分类器进行答案预测。

整个系统使用交叉熵损失函数以端到端的方式训练。

四、实验

在VQA v2.0和TDIUC数据集上,我们将我们提出的MLIN方法与以往最先进的方法进行了比较,下图是比较结果。

下图是我们将前三个视觉注意力权重可视化,以创建视觉概要向量。