论文地址:https://arxiv.org/abs/1905.11946

笔记内容:

-

论文总览

-

论文图表与内容

-

MBConv

论文总览:

1、卷及网络中仔细地平衡网络的宽度、深度和分辨率是一个重要而缺失的环节,使我们无法获得更好的精度和效率

2、提出了一种复合比例法,使得baseline网络能有效地扩展,使用更少的参数达到更好的准确率

3、使用卷积架构搜索,设计并扩展了模型,获得一系列网络——EfficientNets

论文图表与内容:

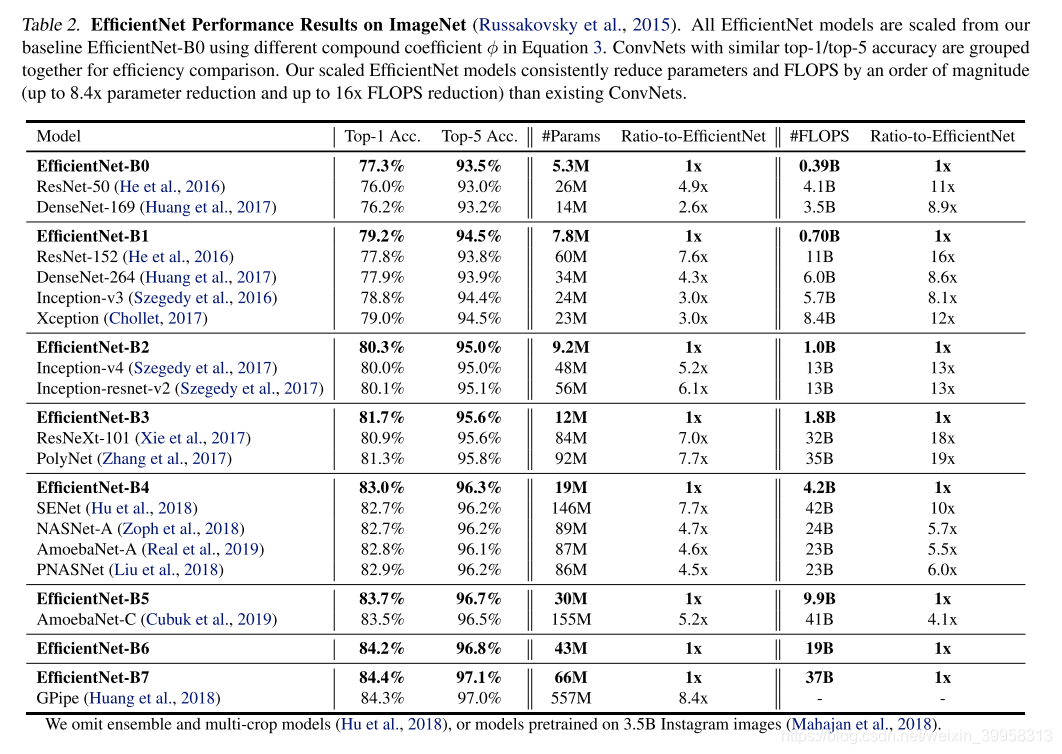

EfficientNets优于其他CNN网络,尤其,EfficientNet-B7超越了之前最好的GPipe的精度,但是参数量少了8.4倍、速度快了6.1倍。

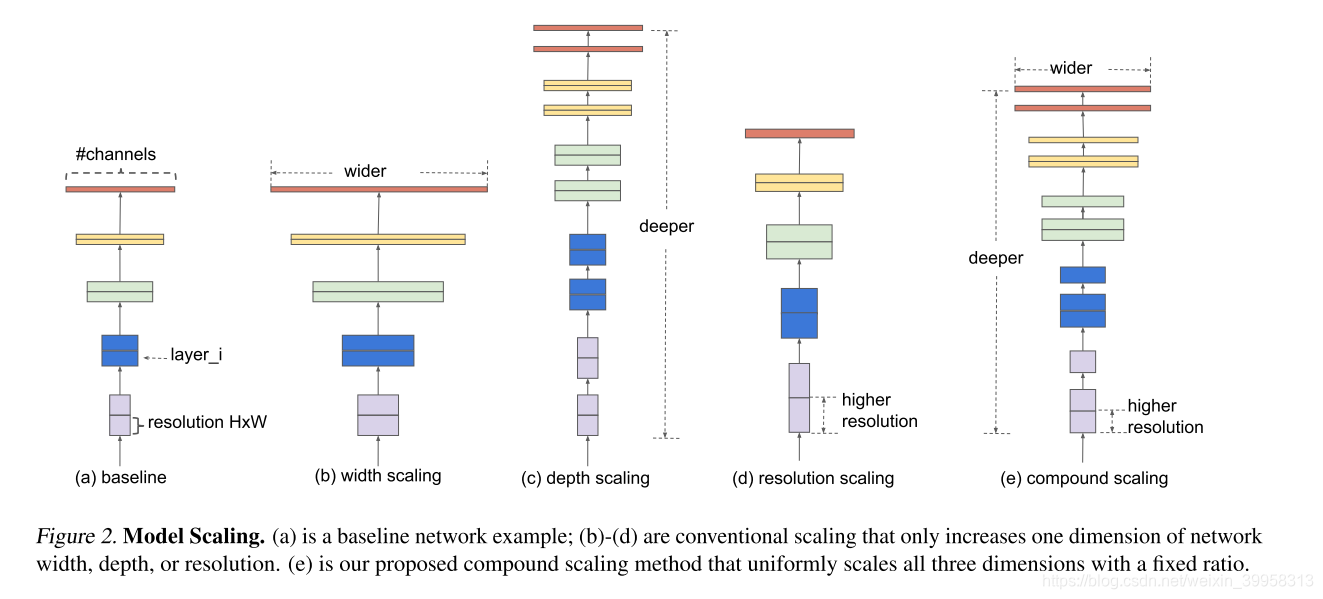

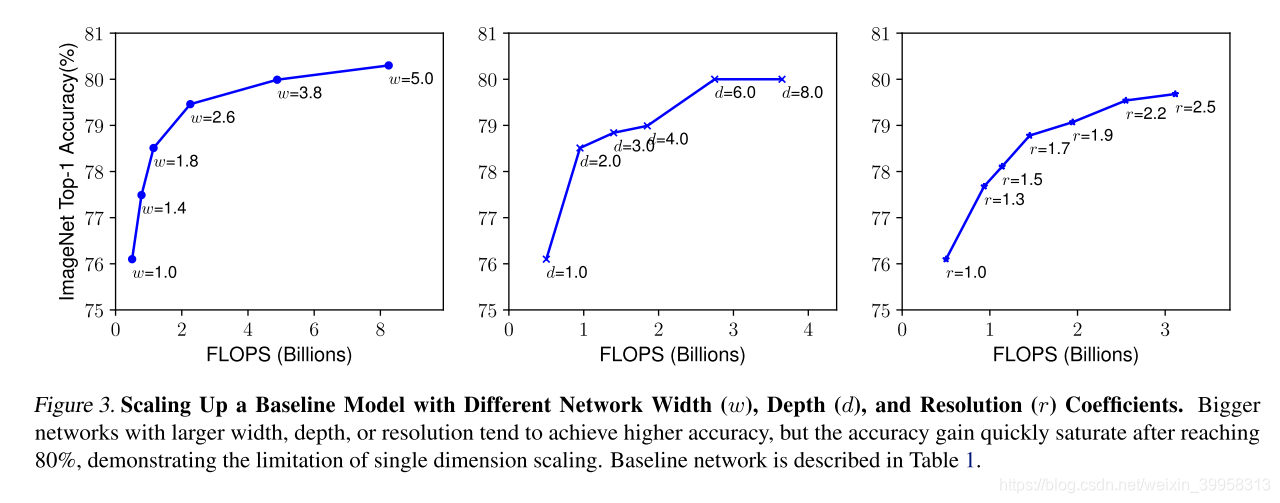

更深的卷积可以捕获更丰富更复杂的特征,但容易出现梯度消失的问题,跳阶连接和BN可以缓解;更广泛的网络往往能够捕获更细粒度的特征,并且更易于训练,但极宽但较浅的网络在捕获更高层次的特征方面往往有困难,使用更大分辨率的输入尺寸,可以潜在地捕获更多细粒度的特征

更高的图像分辨率需要更深的网络,这样在更大的图像中有更大的感受野才能捕获与原先相似的特征 。同样,增加图像分辨率也要相应地增加网络的宽度,在高分辨率图像中使用更多像素捕获更细粒度的模式。

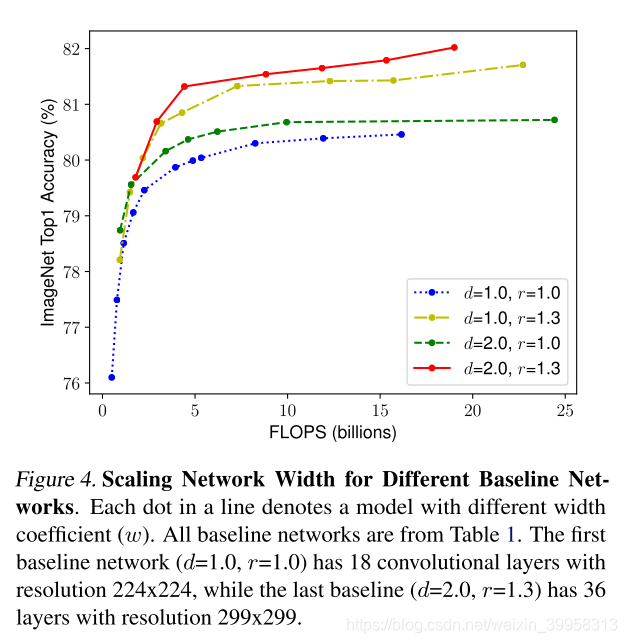

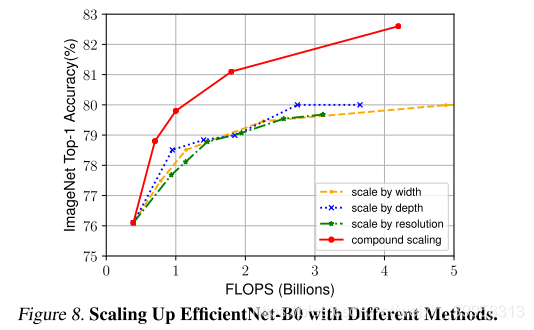

在网络深度和分辨率都不变时,在网络宽度上缩放,很快就饱和了,但是如果把深度和分辨率都扩大后,在相同的FLOPS损耗下,宽度缩放会获得更高的准确率

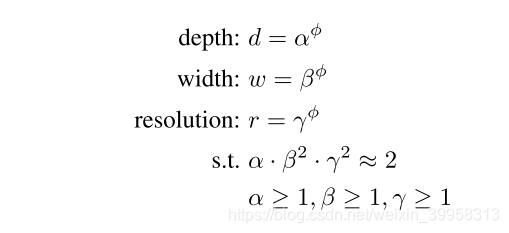

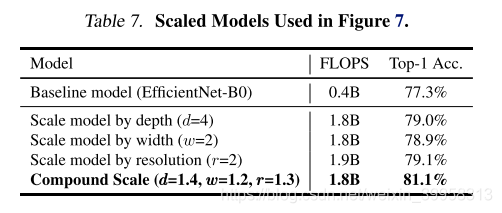

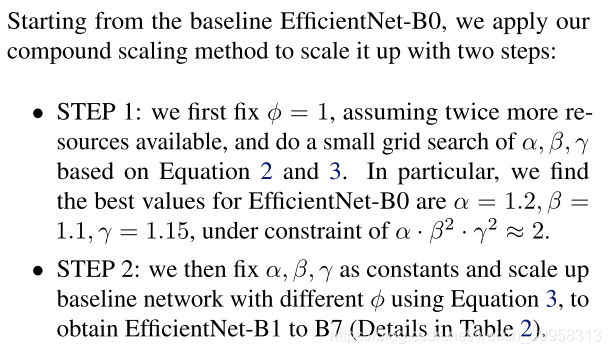

复合系数的计算:

这里的α,β,γ都是由一个很小范围的网络搜索得到的常量,直观上来讲,ϕ是一个特定的系数,可以控制用于资源的使用量,α,β,γ决定了具体是如何分配资源的。值得注意的是,常规卷积op的计算量,加倍深度会使得FLOPS加倍,但是加倍宽度和分辨率会使得FLOPS加4倍。由于卷积ops经常在CNN中占据了大部分计算量,在本篇论文中,我们对任意ϕ增加了约束α⋅β2⋅γ2≈2,整体的计算量近似增加了2^ϕ 倍

相比于广泛使用的ResNet-50,我们的EfficientNets-B4在相近的FLOPS下将top-1精度从76.3%提高到了82.6%。

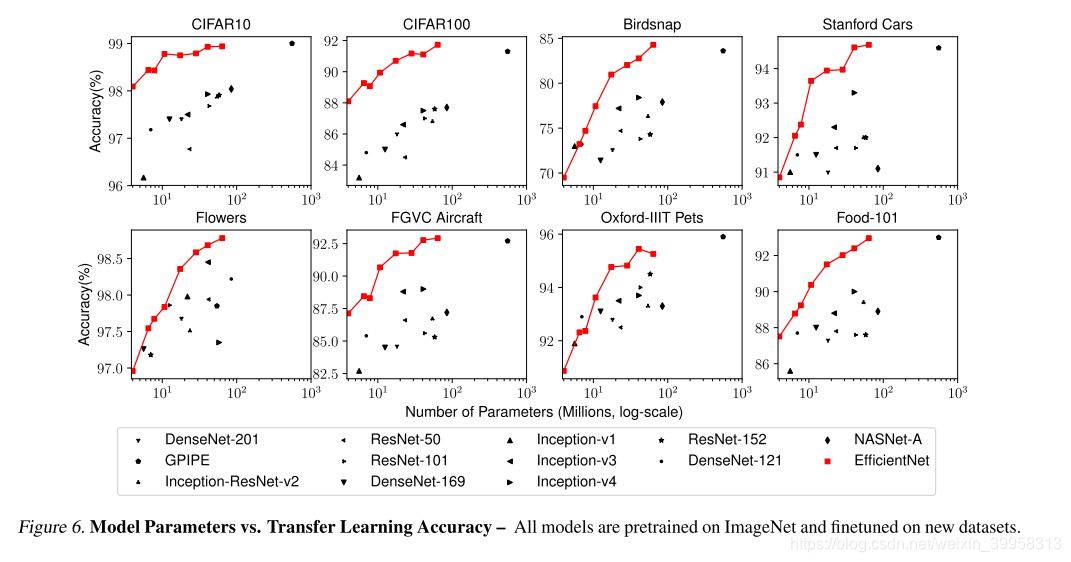

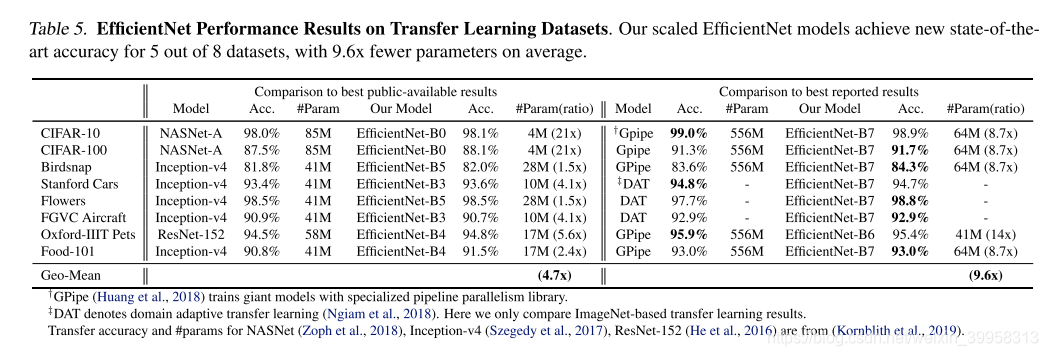

除了ImageNet,EfficientNets在其他数据集上表现也很好,在8个广泛应用的数据集中的5个实现了最先进的精度,然而比存在的卷积网络的参数量减少了21倍

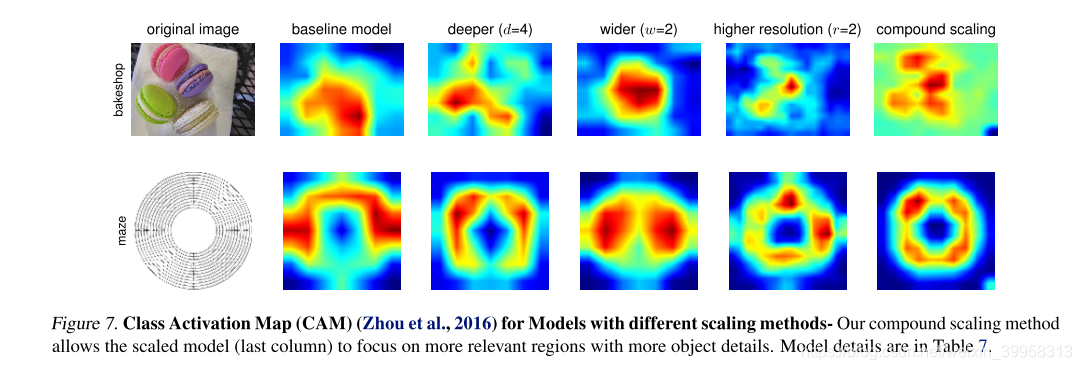

CAM图:图片是随机从验证集中得到的,正如在figure中可见,复合缩放得到的模型倾向聚焦于与更多目标细节相关的区域,而其他的模型要么缺乏目标细节,要么不能捕捉到图片中所有的目标。

复合缩放方法后精度的提升效果

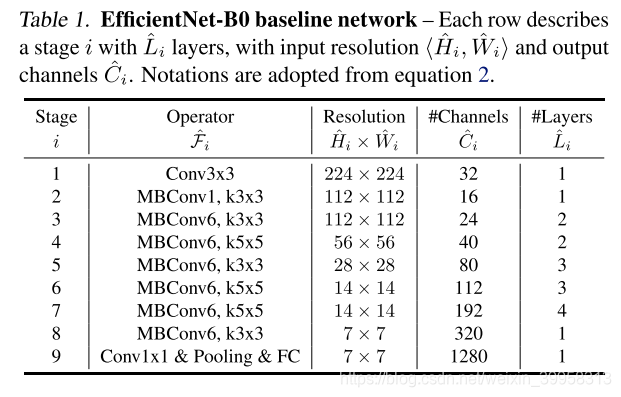

EfficientNet网络结构

确定复合系数的步骤

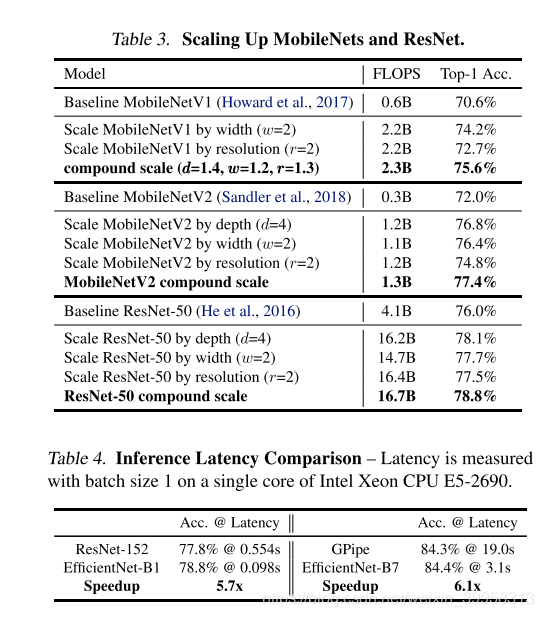

缩放方法应用到MobileNets和ResNets中,Table 3展示了以不同的方法缩放的ImageNet结果。与其他单一维度的缩放方法相比,复合缩放方法精度提高了。

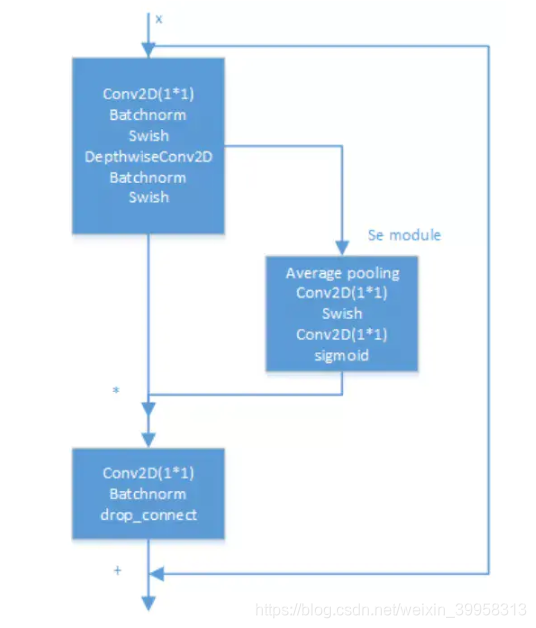

MBConv

MBConv参考文章:https://www.jianshu.com/p/5449ce4de7cc

swish参考文章:https://blog.csdn.net/FontThrone/article/details/78636353

MBConv

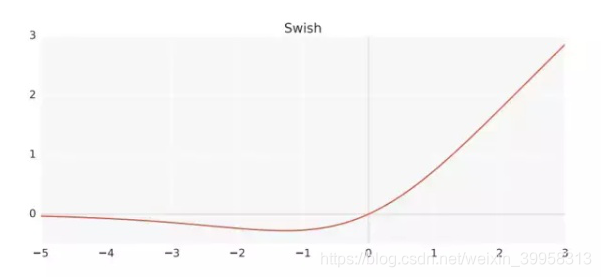

Swish激活函数

f(x)=x * sigmod(x),

变形Swish-B激活函数的公式则为f(x)=x * sigmod(b * x)

其拥有不饱和,光滑,非单调性的特征