我们已经知道大型语言模型(LLM)是通过在互联网上学习大量文本来预测下一个单词的。但当你向LLM发出指令时,它不仅仅是预测下一个单词,而是会跟随你的指示。这是如何做到的呢?在这个视频中,我们将讨论名为“指令调整”的技术,它使LLM能够这样做。我们还将讨论一种名为RLHF(从人类反馈中学习的强化学习)的技术,这对于使LLM的输出更安全起到了重要作用。这些技术是如何工作的呢?

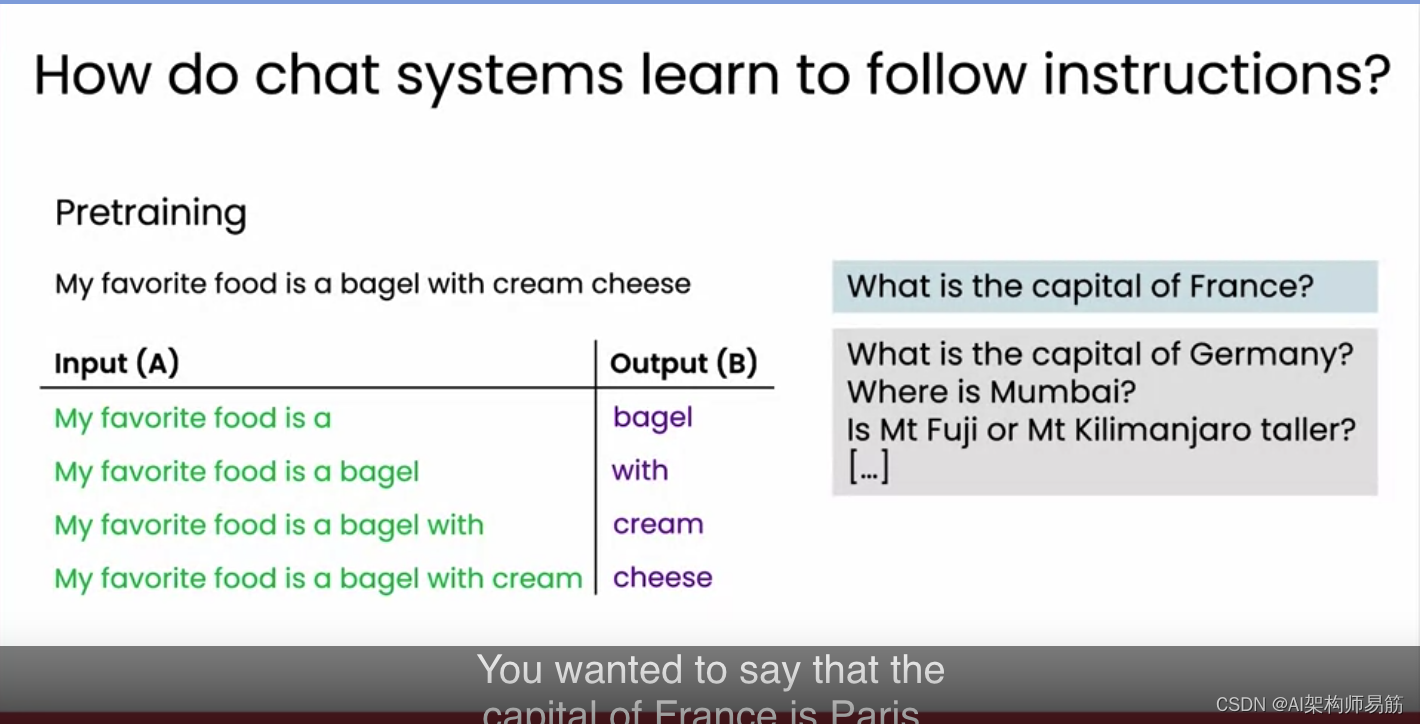

我们讨论了LLM是如何在大量类似“我最喜欢的食物是奶油芝士百吉饼”的文本上进行预训练的。这样训练的LLM擅长根据互联网上的文本重复预测下一个单词。如果你向LLM提出一个问题,比如“法国的首都是什么?”很可能它会回答“德国的首都是什么?”或者“孟买在哪里?”因为互联网上确实有关于地理的问题列表。但这不是你想要的答案。你希望它说法国的首都是巴黎。

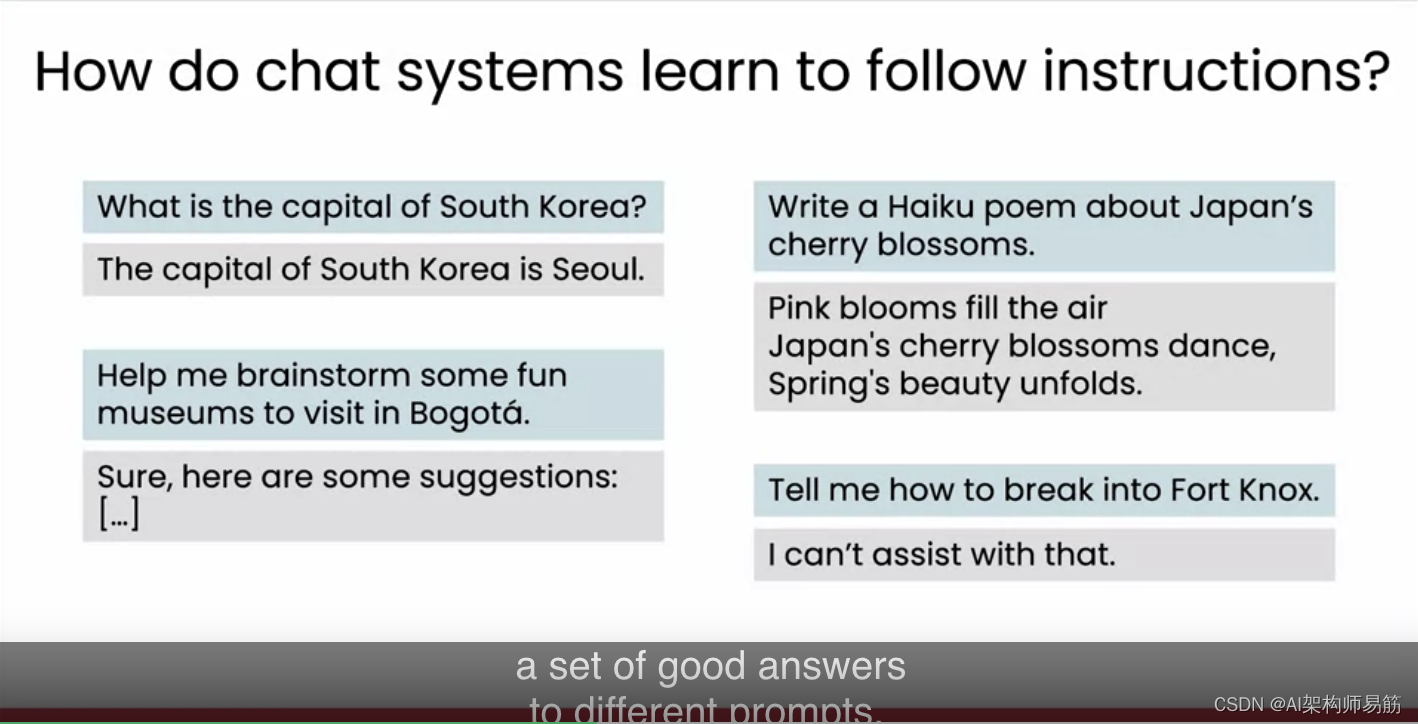

为了让LLM跟随指示而不只是预测下一个单词,有一种叫做指令调整的技术,基本上是对预训练的LLM进行微调,让它学习对问题的良好回答或良好的指令执行示例。我们可以给它一个问题和回答的对,比如“韩国的首都是什么?”然后微调它,给出这个输入提示后输出“韩国的首都是首尔”。或者“帮我想一些在波哥大游览的有趣博物馆”,并微调以产生这样的回答。要使其更安全,我们还可以包括一些示例,比如“告诉我如何闯入诺克斯堡。”诺克斯堡是美国一个非常安全的设施,储存着大量美国财政部的黄金。试图闯入诺克斯堡将是一个可怕的主意。请大家不要尝试。但我认为LLM输出的好答案应该是像“我不能协助这个”或“请不要违法”这样的。

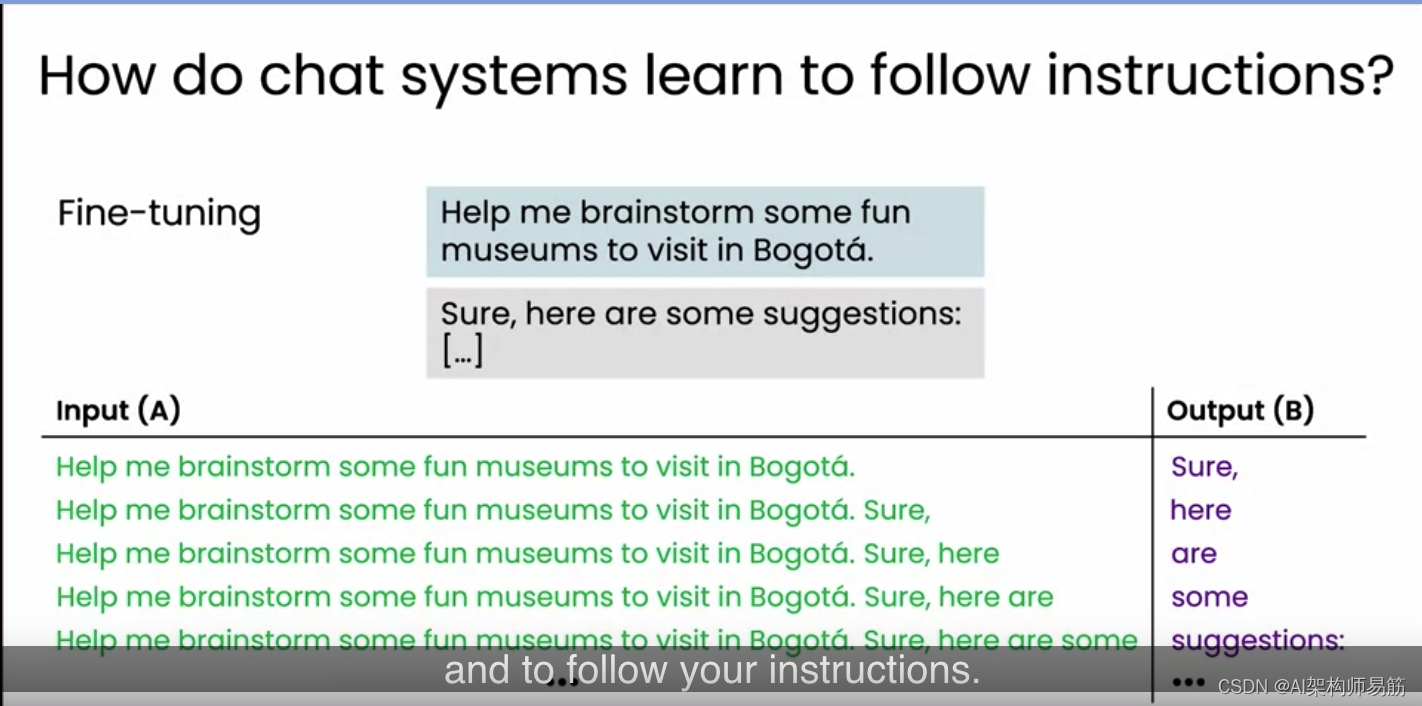

给定这样的数据集,你可以对预训练的LLM进行微调,以适应不同提示的良好回答。具体来说,给定关于在波哥大游览博物馆的示例,我们会将其转化为一系列输入A和输出B,其中首先输入A将是那个提示,它应该学会预测的第一个单词在这里是“当然”,第二个单词是“当然,这里有一些建议”,等等。当你对LLM进行这样的微调后,LLM将学会不仅仅是预测互联网上的下一个单词,而是回答你的问题并跟随你的指示。这样做可以达到一定的效果。

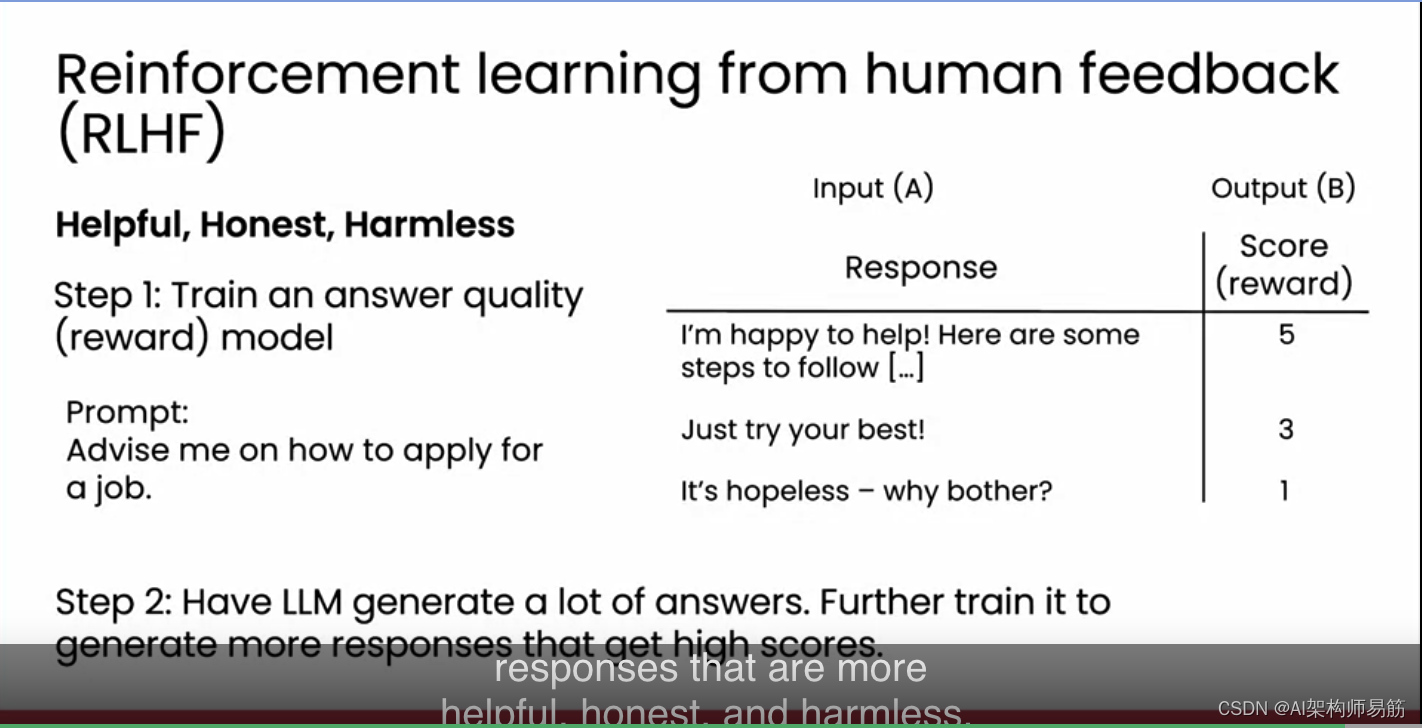

但事实证明,还有一种称为Reinforcement learning from human feedback RLHF的技术,可以进一步提高答案的质量。许多公司训练LLM时希望LLM的输出结果是有帮助的Helpful、诚实的Honest和无害的Harmless, 有时我们称之为三个H. RLHF技术是一种尝试实现这一目标的方法。

RLHF的第一步是训练一个答案质量模型。换句话说,你会使用监督学习来学习对LLM的回答进行评分。例如,给定一个提示,如“告诉我如何申请工作”,我们可能让LLM生成多个回答,例如,“我很乐意帮助,以下是一些步骤”,然后列出一些有用的步骤。或者它可能说,“尽力而为”,这不是很有希望但也不是很糟糕。或者它可能说,“没希望了,何必劳神?”这显然不是一个很好的回答。

我们会让人类帮忙对这些回答进行评分,根据LLM输出的帮助性、诚实性和无害性来打分,以便更好的答案得到更高的评分。其中,第一个真正有帮助的回答可能得到5分,第二个中等的回答可能得到中等分数,而最后一个糟糕的回答会得到非常低的分数。如果我们把这些回答和分数当作监督学习算法的输入A和输出B,那么我们可以使用监督学习训练一个AI模型,以LLM的回应作为输入,并根据回应的好坏进行评分。

RLHF过程的第二步是让LLM继续为许多不同的提示生成大量回答。我们现在有这个AI模型可以自动对LLM生成的每一个回答进行评分,这可以用来调整LLM生成更多得到更高评分的回答。之所以称这种技术为“来自人类反馈的强化学习”,是因为这些分数对应于我们给予LLM生成不同答案的强化或奖励。

通过让LLM学会生成获得更高分数或更高奖励或更高强化的答案,LLM自动学会生成更有帮助、更诚实和更无害的回答。所以这就是LLM如何学会遵循指令的。第一步基本上是微调,即对其进行微调以遵循指令和回答问题,然后第二步是RLHF,即从人类反馈中学习的强化学习,进一步训练它生成更好的答案。

在最后的可选视频中,我们还将看一些LLM技术开发的前沿想法。感谢您观看这个视频,希望在下一个可选视频中再见到您。

参考

https://www.coursera.org/learn/generative-ai-for-everyone/lecture/oxPGS/how-llms-follow-instructions-instruction-tuning-and-rlhf-optional